La sortie cette semaine aux dĂ©veloppeurs enregistrĂ©s de CUDA est l’accomplissement de milliers d’heures dĂ©diĂ©es Ă ce projet. Cette technologie peut sembler jeune, sa première version, la 1.0, n’a Ă©tĂ© sortie qu’en 2007. L’effet de cette sortie sur le monde entier n’a, sans nul doute possible, pas Ă©tĂ© nul. Elle n’est pas non plus le seul terrain d’avance pour les technologies massivement parallèles sur matĂ©riel NVIDIA : les API comme OpenCL et DirectCompute sont elles aussi supportĂ©es et amĂ©liorĂ©es, en plus d’un accès direct au GPU en C, C++ et Fortran.

Comme toujours, NVIDIA est Ă la recherche d’aide sur le sujet, notamment au niveau des retours d’utilisateurs, d’amĂ©liorations possibles, des bogues ; tout ce qui vous empĂŞche de dĂ©velopper rapidement, de dĂ©ployer des applications sans souci, tout cela doit ĂŞtre amĂ©liorĂ©. Si vous ĂŞtes intĂ©ressĂ© dans cette perspective, n’hĂ©sitez pas Ă vous enregistrer comme dĂ©veloppeur.

Le contenu de CUDA 4.0

Venons-en au fait de cette sortie prochaine, vendredi 4 mars aux développeurs enregistrés.

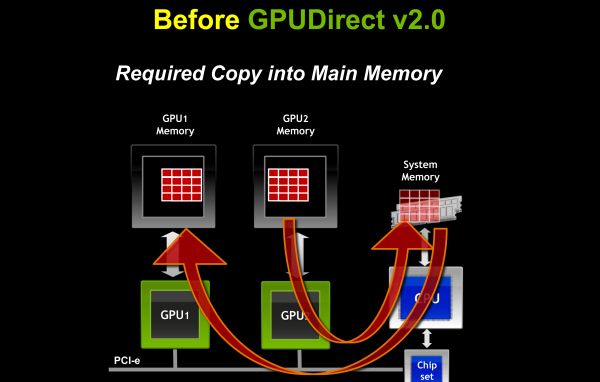

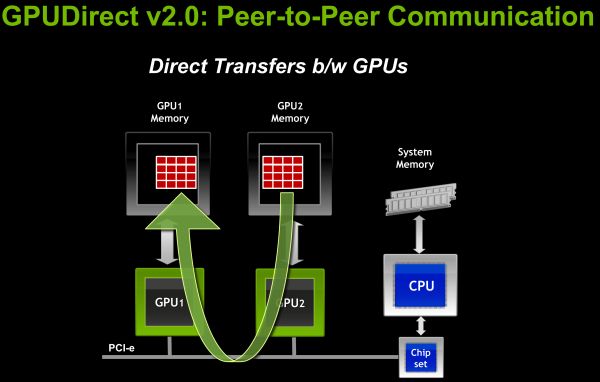

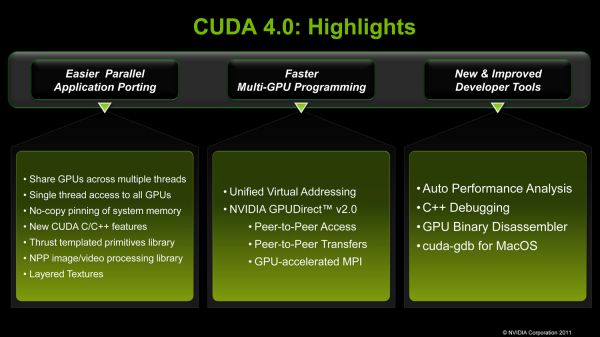

Notons la version 2.0 de GPUDirect, une technologie qui offre un support pour des communications entre les GPU d’un serveur ou d’une station de travail, une fonctionnalitĂ© que beaucoup dĂ©crivent comme un outil pour un dĂ©veloppement plus rapide et plus aisĂ© pour plusieurs GPU, ainsi qu’un vecteur d’amĂ©liorations de performances.

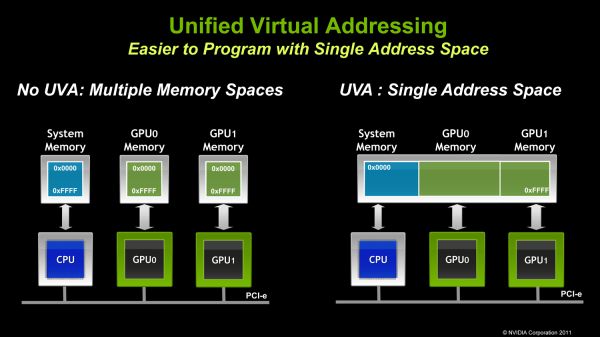

UVA, acronyme de Unified Virtual Addressing, permet d’utiliser un espace d’adressage mĂ©moire unifiĂ© entre la mĂ©moire du système et celles des GPU.

Aussi, grande nouveauté par rapport aux versions précédentes de CUDA, le partage entre divers threads de GPU : plusieurs threads ou processus sur le CPU peuvent utiliser le même GPU pour leurs calculs. De même, un même thread CPU peut utiliser plusieurs GPU en même temps. Thrust est désormais intégré dans CUDA, le portage de la STL du C++ aux technologies du GPU.

Pour les amateurs de C++, de nouvelles fonctionnalités propres au langage sont désormais supportées, comme les fonctions virtuelles, ainsi que les mots clés new et delete pour la gestion de la mémoire allouée.

Sources : http://blogs.nvidia.com/2011/03/announcing-cuda-4-0/, http://developer.nvidia.com/object/cuda_4_0_RC_downloads.html, http://www.ddj.com/high-performance-computing/229219474;jsessionid=YAXVYSIIVLYCTQE1GHPSKH4ATMY32JVN, http://www.anandtech.com/show/4198/nvidia-announces-cuda-40 (d’oĂą proviennent les images)