Les compilateurs sont des programmes informatiques d’une importante complexitĂ©. Ils sont gĂ©nĂ©ralement structurĂ©s en une partie frontale, qui comprend le langage d’entrĂ©e, puis d’une partie arrière, qui s’occupe de traduire le programme d’entrĂ©e en du code binaire exĂ©cutable par le processeur. Les deux parties communiquent Ă l’aide d’une reprĂ©sentation intermĂ©diaire (IR). Ainsi, pour qu’une mĂŞme suite de compilateurs comprenne plusieurs langages et puisse gĂ©nĂ©rer du code pour plusieurs processeurs, il n’est pas nĂ©cessaire d’Ă©crire un compilateur spĂ©cifique pour chaque paire langage-processeur : il suffit d’Ă©crire les paires langage-IR et IR-processeur. Tout le travail effectuĂ© pour un processeur sera alors utilisable pour n’importe quel langage d’entrĂ©e.

Dès la gĂ©nĂ©ration du code intermĂ©diaire, un compilateur utilise Ă©normĂ©ment de passes d’optimisation, afin de rendre le code plus rapide. Elle utilise des techniques comme la propagation des valeurs : si une variable a une valeur connue Ă un endroit du code (initialisation, condition…), alors cette valeur peut ĂŞtre propagĂ©e dans une sĂ©rie de calculs, qui seront alors effectuĂ©s Ă la compilation au lieu de l’exĂ©cution. Ces passes sont effectuĂ©es en partie sur la reprĂ©sentation intermĂ©diaire, pour les optimisations indĂ©pendantes du processeur, mais Ă©galement sur du code machine dĂ©jĂ gĂ©nĂ©rĂ©, pour tirer le meilleur parti possible du matĂ©riel.

GĂ©nĂ©ralement, cette phase d’optimisation est extrĂŞmement cruciale, Ă©tant donnĂ© que la reprĂ©sentation intermĂ©diaire est suffisamment gĂ©nĂ©rale pour plusieurs types de processeurs et relativement simple dans les instructions disponibles : pour effectuer certaines opĂ©rations, il est parfois nĂ©cessaire d’Ă©crire des dizaines d’instructions IR, alors que certains processeurs peuvent rĂ©aliser la mĂŞme opĂ©ration en une seule instruction. De plus, une reprĂ©sentation intermĂ©diaire doit ĂŞtre prĂŞte pour les phases d’optimisation qui suivent, notamment en simplifiant toutes les Ă©tapes de raisonnement : dans les IR de type SSA, notamment, une variable ne peut ĂŞtre assignĂ©e qu’une seule fois, ce qui allonge d’autant plus le code.

Un nouvel optimiseur pour Visual C++

Le compilateur C++ de Microsoft, connu sous le nom de Visual C++, a longtemps Ă©tĂ© laissĂ© dans un Ă©tat proche de l’abandon. Depuis quelques annĂ©es, les Ă©quipes de dĂ©veloppement ont mis les bouchĂ©es doubles pour ramener le compilateur dans la course, avec une compatibilitĂ© avec les normes les plus rĂ©centes, au niveau de GCC ou Clang. Depuis lors, ils ont effectivement rattrapĂ© en grande partie leur retard Ă ce niveau, mais pas encore pour les optimisations du code.

L’optimiseur actuel ne disposait que d’une sĂ©rie de transformations assez basiques, n’exploitant qu’une vue assez limitĂ©e des fonctions. Bon nombre d’optimisations fonctionnent en trouvant des motifs et en les remplaçant par une version amĂ©liorĂ©e, mais tous les motifs les plus utiles ne sont pas toujours implĂ©mentĂ©s. De plus, le code vectorisable n’est pas optimisĂ© au meilleur de ses possibilitĂ©s. Toutes ces limitations ont une origine historique : le compilateur C++ de Microsoft a des origines très anciennes, il provient de l’Ă©poque DOS oĂą la mĂ©moire Ă©tait très limitĂ©e, ce qui limite les possibilitĂ©s. Les efforts actuels portent principalement sur une modernisation du code, en Ă©liminant les compromis d’un autre âge.

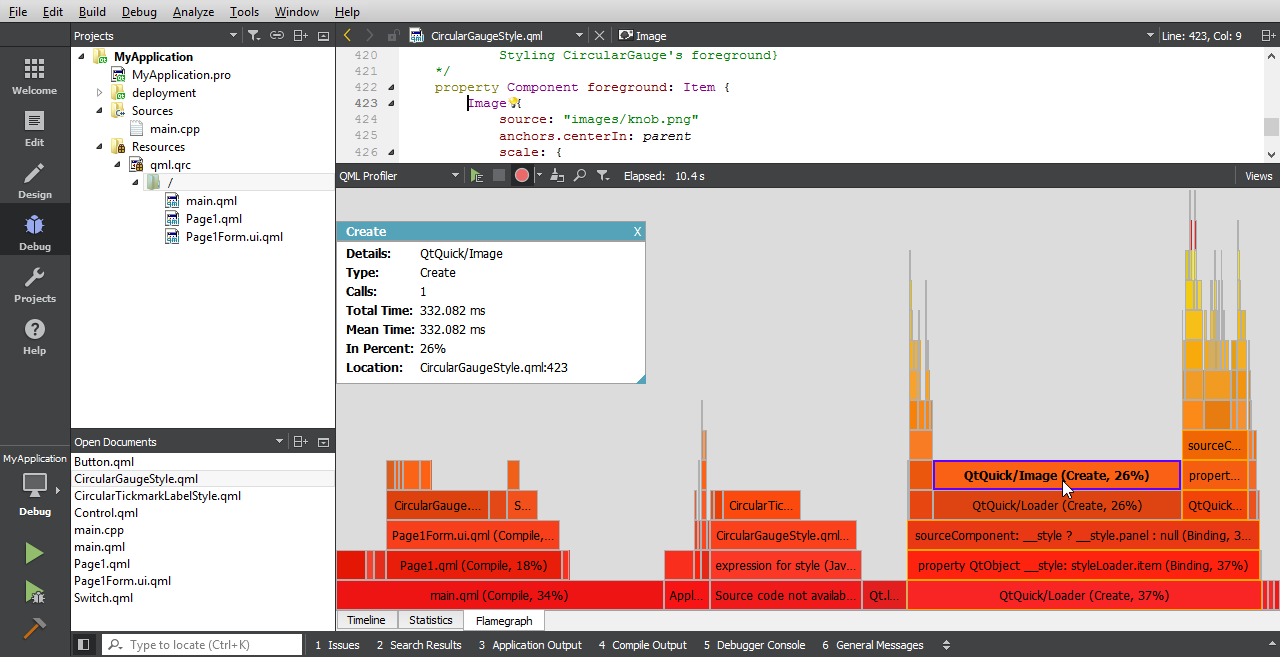

Le nouvel optimiseur exploite dĂ©sormais une reprĂ©sentation intermĂ©diaire SSA. Les algorithmes implĂ©mentĂ©s par-dessus peuvent ainsi ĂŞtre plus efficaces en temps par rapport aux approches par analyse du flux de donnĂ©es. Il se base sur une bibliothèque C++ avancĂ©e, exploitant les templates Ă foison, pour dĂ©crire les transformations Ă effectuer, ce qui a permis d’ajouter bon nombre d’optimisations simples en très peu de temps (surtout par rapport Ă l’infrastructure prĂ©cĂ©dente).

Les dĂ©veloppeurs de Visual C++ indiquent Ă©galement avoir prĂŞtĂ© attention Ă la correction de ces optimisations : il n’y a rien de plus dĂ©sagrĂ©able que de passer des journĂ©es Ă dĂ©boguer son code pour trouver que, finalement, le problème n’est pas dĂ» au code, mais bien au compilateur. Linus Torvalds a rĂ©cemment torpillĂ© GCC Ă ce sujet. Ici, les dĂ©veloppeurs ont absolument cherchĂ© Ă Ă©viter ces Ă©cueils, en testant leurs passes d’optimisation sur des programmes courants comme Chrome ou Firefox, puis sur des bibliothèques imposantes cĂ´tĂ© Microsoft comme CoreCLR ou Chakra.

Ils ont aussi employĂ© des techniques de vĂ©rification formelle (Ă l’aide d’ALIVE et l’outil de dĂ©monstration automatique Z3, tous deux issus de Microsoft Research et aussi utilisĂ©s pour LLVM) et de la gĂ©nĂ©ration de code alĂ©atoire avec Csmith (et C-Reduce pour rĂ©duire le code posant problème au strict minimum). Certains outils du projet LLVM ont pu ĂŞtre utilisĂ©s, puisque Visual C++ peut en exploiter les parties avant, comme Opt-fuzz, qui gĂ©nère des expressions arithmĂ©tiques Ă optimiser.

Un exemple

Ces nouvelles optimisations peuvent avoir un effet assez radical sur certains bouts de code. Par exemple, pour un test de parité :

int test(int a) {

return a % 2 != 0 ? 4 : 2;

}

Les précédentes versions du compilateur produisaient un code qui prenait entre cinq et dix cycles en x86, selon que tout le processeur est exploité (prédiction du branchement parfaite) ou non :

?test@@YAHH@Z PROC

and ecx, -2147483647

jge SHORT $LN3@test

dec ecx

or ecx, -2

inc ecx

$LN3@test:

test ecx, ecx

mov eax, 2

mov edx, 4

cmovne eax, edx

ret 0

Sauf que… Dans le test a % 2 == 0, le signe de a n’a aucune espèce d’importance, seul un bit est important : le modulo peut ĂŞtre remplacĂ© par une opĂ©ration logique, c’est-Ă -dire a & 1 == 0. Or, la comparaison implique un branchement dans le code, forcĂ©ment lent sur les architectures x86 modernes : pour s’en dĂ©barrasser, la structure bool(a) ? C1 : C2 peut ĂŞtre remplacĂ©e par C2 + a*(C1-C2), c’est-Ă -dire exclusivement des calculs. Par consĂ©quent, le nouveau code assembleur est le suivant :

?test@@YAHH@Z PROC

and ecx, 1

lea eax, DWORD PTR [rcx*2+2]

ret 0

Celui-ci prend, Ă tous les coups, deux cycles d’horloge : par rapport Ă cinq Ă dix cycles, le gain est important, tant en rapiditĂ© qu’en taille de l’exĂ©cutable.

D’autres mĂ©canismes effectuent une analyse statique du code, en prĂ©calculant autant de bits que possible dans les variables. Par exemple, lors d’une conversion vers un type plus grand, une sĂ©rie de bits est forcĂ©ment Ă zĂ©ro, peu importe la valeur d’entrĂ©e. Ensuite, cette information peut ĂŞtre adaptĂ©e en fonction des opĂ©rations effectuĂ©es, ce qui peut guider le reste du processus.

int test(unsigned char a) {

short b = a; // b: 00000000________, a: ________

b <<= 4; // b: 0000________0000

b |= 3; // b: 0000________0011

return b != 0; // -> return true

}

Impact sur la taille du code généré

L’impact de ces modifications sur le code gĂ©nĂ©rĂ© n’est pas facile Ă Ă©tablir : certaines optimisations diminuent forcĂ©ment la quantitĂ© de code, le compilateur sera alors plus enclin Ă recopier in extenso le code de petites fonctions pour Ă©viter le surcoĂ»t dĂ» Ă tout appel de fonction (qui n’est nĂ©gligeable que pour des fonctions plus grandes) — ce qui conduit Ă l’augmentation de la taille du code. Il n’empĂŞche, les rĂ©sultats sont intĂ©ressants : sur tout Windows, c’est-Ă -dire plus d’un gigaoctet, les gains sont de 438 Ko par rapport Ă l’optimiseur prĂ©cĂ©dent (0,3 %) ; sur SQL Server, 46 Ko sur 64 Mo (0,8 %) ; sur Chakra, le nouveau moteur JavaScript, 10 Ko sur 6 Mo (1,7 %).

En analysant plus en dĂ©tail l’impact au niveau des instructions, les plus lentes sont largement Ă©vitĂ©es (branchements, multiplications, divisions), remplacĂ©es par des opĂ©rations plus rapides (comme des dĂ©placements conditionnels). Les temps de compilation ont Ă©tĂ© impactĂ© de diverses manières : une augmentation de 1,7 % pour Chrome ou une diminution de 2,6 % pour le noyau Windows.

Et alors ?

Les travaux sur l’optimiseur viennent seulement d’ĂŞtre annoncĂ©s : l’architecture choisie permettra aux dĂ©veloppeurs d’ajouter des optimisations supplĂ©mentaires rapidement (et certaines sont dĂ©jĂ en cours de planification). Cet optimiseur devrait arriver dès Visual C++ 2015 Update 3, mais le travail continuera sur cet aspect du compilateur, afin de le rendre compĂ©titif par rapport Ă ses concurrents, voire de les dĂ©passer. Il est d’ores et dĂ©jĂ possible de le tester.

Source : Introducing a new, advanced Visual C++ code optimizer.

L’image a Ă©tĂ© crĂ©Ă©e par l’auteur et est soumise au droit d’auteur.