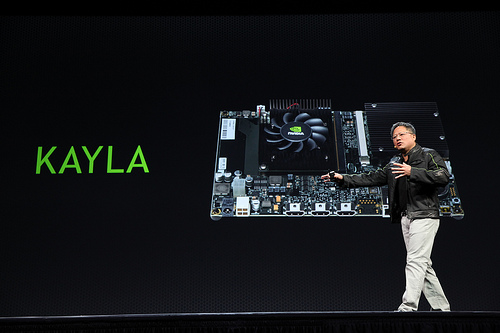

NVIDIA, producteur historique de cartes graphiques, s’Ă©tait rĂ©cemment lancĂ© dans les processeurs ARM, utilisĂ©s dans certains appareils mobiles (avec un GPU intĂ©grĂ©). Une grande rĂ©volution est venue ces dernières annĂ©es dans le secteur des GPU : leur utilisation pour des calculs non graphiques, fournissant mĂŞme la plus grosse partie de la puissance de calcul du superordinateur le plus rapide du moment (voir le top 500 de novembre 2012). Il semblait logique de vouloir combiner ces deux aspects – ce sera bientĂ´t chose faite, avec la plateforme Kayla.

Cette plateforme est constituĂ©e d’un processeur mobile Tegra avec un GPU NVIDIA (basĂ© sur l’architecture Kepler), pour une puissance de calcul encore jamais atteinte sur mobile. Parmi les technologies supportĂ©es, on note CUDA 5 et OpenGL 4.3. De manière très physique, cet ensemble n’est pas particulièrement compact (il convient plus pour des tablettes que pour des smartphones), mais donne un avant-goĂ»t des possibilitĂ©s de Logan, la prochaine gĂ©nĂ©ration de processeurs Tegra (qui sera bien plus compacte que Kayla).

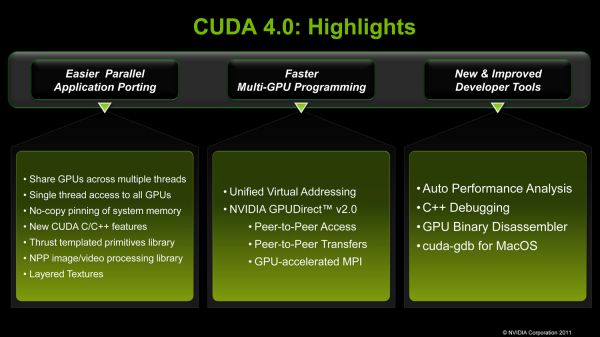

Avec le support d’OpenGL 4.3, on peut s’attendre Ă des effets graphiques bien plus avancĂ©s que ce que l’on trouve actuellement sur les applications mobiles (avec le support de la tessellation, notamment). CUDA 5 est une plateforme très avancĂ©e de GPGPU : on pourrait s’attendre Ă avoir des applications de reconnaissance (faciale, d’objets, etc.) très rapides et efficaces sur des tĂ©lĂ©phones. Ainsi, les performances de ces appareils deviennent comparables avec les performances d’un ordinateur plus classique.

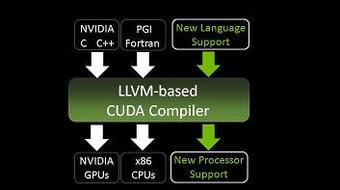

Le portage de code ne devrait pas ĂŞtre d’une complexitĂ© Ă©norme. NAMD, un logiciel de simulation de dynamique molĂ©culaire, a Ă©tĂ© portĂ© en deux jours sur cette nouvelle plateforme ; le logiciel de lancer de rayons de NVIDIA, OptiX, a, lui, Ă©tĂ© portĂ© en une journĂ©e Ă peine.

Source : http://blogs.nvidia.com/2013/03/gpu-computing-comes-to-tegra/