Pour mon 1er billet, je vais vous faire part d’une discussion intĂ©ressante que j’ai eu avec un de mes responsables de travail concernant la parallĂ©lisation des requĂŞtes sur SQL Server. En effet les premiers temps oĂą je suis arrivĂ© dans l’entreprise, on m’a prĂ©sentĂ© l’infrastructure informatique et un des serveurs sur lequel j’allais exercer mes fonctions de DBA.

Ce serveur a des caractĂ©ristiques plutĂ´t intĂ©ressantes. (2 Processeurs Intel Xeon 2 quadricoeur 2,33GHz avec 8 Go de RAM et un peu plus de 1 TĂ©ra Octets d’espace disque pour hĂ©berger les donnĂ©es avec une version SQL Server 2005 Entreprise Edition). Ce serveur hĂ©berge 16 bases de donnĂ©es qui fonctionnent toutes en environnement OLTP et oĂą l’activitĂ© transactionnelle est plutĂ´t soutenue.

Cependant mon responsable a Ă©tĂ© surpris quand je lui ai annoncĂ© qu’il Ă©tait bien souvent inutile de laisser la parallĂ©lisation activĂ©e dans ce genre d’environnement et qu’Ă l’inverse on risquait de perdre en performance. Il a fallu bien Ă©videmment le lui prouver.

Alors commençons par poser le dĂ©cor : La parallĂ©lisation c’est quoi au juste ? Et comment peut t’on savoir si celle-ci dĂ©tĂ©riore les performances plutĂ´t que le contraire ?

Les serveurs actuels sont gĂ©nĂ©ralement multiprocesseurs et multicoeurs. Cette architecture permet Ă SQL Server de pouvoir parallĂ©liser l’exĂ©cution d’une requĂŞte lorsqu’il le dĂ©sire en fonction de son coĂ»t et de l’occupation du système. Les requĂŞtes qui sont le plus souvent candidates Ă cette opĂ©ration sont les requĂŞtes longues et celles qui sont composĂ©es de plusieurs autres petites requĂŞtes. On les retrouve volontiers dans des environnements plutĂ´t de type OLAP.

A contrario, dans un environnement de type OLTP la plupart des requêtes sont courtes et nombreuses. Par conséquent le coût engendré pour une éventuelle parallélisation peut devenir important car cette opération nécessite une synchronisation de tous les processeurs candidats. On peut donc assister à des ralentissements et une détérioration des performances dans certains cas.

SQL Server se rĂ©fère Ă certains paramètres de configuration du serveur pour dĂ©cider d’une parallĂ©lisation de requĂŞte. Ces paramètres sont disponibles via la procĂ©dure sp_configure et sont des options avancĂ©es. On en dĂ©nombre 3 :

- affinity mask : ce paramètre permet d’attribuer Ă SQL Server certains ou tous les processeurs disponibles sur le serveur.

- max degree of parallelism : ce paramètre contrĂ´le le nombre de processeurs candidats Ă la parallĂ©lisation en fonction de ceux disponibles via l’option affinity mask

- cost threshold for parallelism : ce paramètre détermine le coût minimum de référence pour pouvoir exécuter une parallélisation de requête

Â

Comment peut on mesurer ces ralentissements et cette perte de performance ?

Les ralentissements se traduisent par des types d’attentes particuliers. On peut les visualiser via la DMV sys.dm_os_wait_stats qui recense les informations concernant les attentes subies par les threads en cours d’exĂ©cution sur le système. Nous nous intĂ©resserons plus particulièrement au type d’attente CXPACKET.

Le coĂ»t de synchronisation des processeurs se traduit Ă©galement par des temps d’utilisation et des commutations de threads entre processeurs plus important. On peut mesurer ces temps et ces commutations via les compteurs de performance Processeur : %Temps processeur et Système : Changement de contexte /s.Â

Nous avons donc tout ce qu’il faut pour rĂ©aliser nos tests. Ceux-ci ont Ă©tĂ© rĂ©alisĂ© sur la base suivante :

- Pour que les tests soient reprĂ©sentatifs nous avons pris une journĂ©e de travail oĂą le serveur Ă©tait très sollicitĂ© et une oĂą celui-ci fonctionnait en rĂ©gime « stationnaire ».

- La 1ère partie des tests a Ă©tĂ© rĂ©alisĂ© avec dĂ©sactivant la parallĂ©lisation (option « max degree of parallelism » Ă 1, qui permet de n’utiliser qu’un seul processeur dans tous les cas) et la 2ème partie en rĂ©activant la parallĂ©lisation (option « max degree of parallelism » Ă 0, qui permet d’utiliser tous les processeurs candidats)

Voici les rĂ©sultats observĂ©s : (ceux-ci sont Ă peu près similaires pour les 2 tests. Pour cette raison je n’exposerais qu’un seul jeu d’essai)

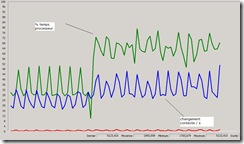

- Utilisation des processeurs :

Â

En vert : % temps processeur

En bleu : Les changements de contexte / s

Â

Â

Â

On observe une augmentation rapide de l’utilisation des processeurs et des changements de contexte lorsqu’on rĂ©active la parallĂ©lisation (2ème partie). Dans le cas de nos tests on observe un gain d’environ 30% ce qui n’est pas nĂ©gligeable !!

Â

- Les attentes :

Â

CXPACKET – Temps d’attente (ms) | Temps d’attente globale (ms) | Ratio

Parallélisation désactivée                                 2                      |                  12908789           | 0,00%

Parallélisation activée                                     4524593             |                  15510535           | 29,17%

On observe que les temps d’attentes CXPACKET reprĂ©sente 30% du temps global d’attente. On voit ici l’intĂ©rĂŞt de dĂ©sactiver la parallĂ©lisation.

Bien entendu ces tests ont convaincu mon responsable ![]() Mais pour ĂŞtre plus sĂ©rieux, dans la plupart des cas il est conseillĂ© de dĂ©sactiver la parallĂ©lisation dans les environnements de type OLTP pour toutes les raisons Ă©voquĂ©es dans l’article. Il existe Ă©galement des best practices Microsoft qui traitent sur ce sujet. Je finirais par le fait que beaucoup d’informaticiens (non DBA) ou de services informatiques misent sur la puissance de leur architecture matĂ©rielle en sur dimensionnant leurs serveurs pour des questions de tranquillitĂ© ou de budget (Eh oui un DBA en plus c’est une ressource en plus !!) sans imaginer que cela puisse ĂŞtre un handicap dans certains cas. J’espère que ce 1er billet vous aura convaincu !!!

Mais pour ĂŞtre plus sĂ©rieux, dans la plupart des cas il est conseillĂ© de dĂ©sactiver la parallĂ©lisation dans les environnements de type OLTP pour toutes les raisons Ă©voquĂ©es dans l’article. Il existe Ă©galement des best practices Microsoft qui traitent sur ce sujet. Je finirais par le fait que beaucoup d’informaticiens (non DBA) ou de services informatiques misent sur la puissance de leur architecture matĂ©rielle en sur dimensionnant leurs serveurs pour des questions de tranquillitĂ© ou de budget (Eh oui un DBA en plus c’est une ressource en plus !!) sans imaginer que cela puisse ĂŞtre un handicap dans certains cas. J’espère que ce 1er billet vous aura convaincu !!!

++ ![]()

David BARBARIN (Mikedavem)

Elève ingénieur CNAM Lyon

Bonjour David,

Je viens de suivre un cours de Paul Randal, un des gars qui a participé au développement de SQL Server.

https://app.pluralsight.com/course-player?clipId=ff1d22d0-4808-41d2-960c-d105a960364d

Dans cette vidĂ©o, il dĂ©montre l’Ă©vĂ©nement d’attente.

Dans ton explication, tu as dĂ©montrĂ© que quand on utilise du parallĂ©lisme, il y a plus d’Ă©vĂ©nements d’attente CXPACKET que quand la requĂŞte est exĂ©cutĂ© par un thread. Ça va de soi et cela n’a pas besoin d’ĂŞtre dĂ©montrĂ©.

Ce qu’il fallait dĂ©montrer, c’est est-ce que le parallĂ©lisme est utile ou non? Oui, il est utile et on n’a pas besoin de le dĂ©sactiver.

Il est utile car les temps de rĂ©ponse sont souvent rĂ©duits lorsque les requĂŞtes sont exĂ©cutĂ©es en parallèle, surtout s’il faut parcourir une grande table partitionnĂ©e par exemple. Si c’est de l’OLTP, avec un accès Ă quelques pages, l’optimiseur est assez intelligent pour ne pas activer le parallĂ©lisme.

Pour rĂ©soudre le problème des attentes excessives du thread de synchronisation CXPACKET, il n’est pas conseillĂ© d’arrĂŞter le parallĂ©lisme mais d’indiquer Ă l’optimiseur Ă partir de quel coĂ»t il faut penser Ă Ă©valuer des plans avec parallĂ©lisme.

Hello m_amziani,

C’est un vieux poste dĂ©terrĂ© celui lĂ :). Je n’ai mĂŞme pas vu le commentaire.

Tout d’abord, je prĂ©cise bien que de dĂ©sactiver le parallĂ©lisme ne constitue en aucun cas une bonne pratique gĂ©nĂ©rale et je prĂ©fère laisser faire SQL Server quand c’est possible (heureusement 99% du temps). Ensuite, tout est question de contexte et changer le cost threshold for parallelism revient pratiquement Ă inhiber le parallèlise sur le un environnement purement OLTP avec transactions courtes si on y rĂ©flĂ©chit. Augmenter le threshold for parallelism reste Ă coup sĂ»r une bonne chose Ă faire car la valeur par dĂ©faut n’est plus adaptĂ©e aux workloads d’aujourd’hui.

Ce qu’il fallait dĂ©montrer, c’est est-ce que le parallĂ©lisme est utile ou non? Oui, il est utile et on n’a pas besoin de le dĂ©sactiver … Si c’est de l’OLTP, avec un accès Ă quelques pages, l’optimiseur est assez intelligent pour ne pas activer le parallĂ©lisme.

J’ai encore des cas oĂą avoir dĂ©sactivĂ© complètement le parallĂ©lisme.. (au niveau de la DB, possible maintenant avec les DB-Scoped configuration) a Ă©tĂ© plutĂ´t salvateur mĂŞme après une augmentation du cost threshold for parallelism. La parallĂ©lisation a un coĂ»t et notamment au niveau de l’estimation d’acquisition mĂ©moire (GRANT MEMORY). Pendant la pĂ©riode COVID-19 ou notre workload a considĂ©rablement augmentĂ©, on s’est dit que ca serait peut ĂŞtre une bonne idĂ©e de laisser faire SQL Server en rĂ©activant le parallĂ©lisme et on s’est vite retrouvĂ© Ă avoir un empilement d’exĂ©cution de requĂŞte en attente avec des types d’attentes SEMAPHORE en pagaille sur notre instance (pas cool quand tu es > 10000 batches/sec). Après rĂ©flexion, notre environnement a finalement très peu de requĂŞtes potentiellement parallèlisables sur la partie purement OLTP .. en gĂ©nĂ©ral une augmentation du coĂ»t (et donc du parallĂ©lisme) dĂ©montre plutĂ´t soit l’absence d’un index pertinent soit une requĂŞte qu’on peut rĂ©Ă©crire et rendre plus efficace … Pour les requĂŞtes Ă fort coĂ»t .. principalement du Reporting, on a dĂ©cidĂ© d’utiliser nos rĂ©plicas secondaires ou nous avons activĂ© le parallĂ©lisme. Dans un autre scĂ©nario nous aurions bien entendu activĂ© le parallĂ©lisme et trouver une bonne valeur du cost threshold for parallelism et surtout revu le dimensionnement de la mĂ©moire… pas le choix

Je suis d’accord avec toi sur pas mal des points que tu cites :

1) 2) 3) 5) et 6) . Je serais tentĂ© de dire que pour un environnement OLTP je prĂ©ferais paramĂ©trer l’option de serveur max degree of parallelism Ă 1 et de jouer avec l’option MAXDOP .. en principe le ratio de requĂŞtes ayant besoin d’une parallĂ©lisation reste faible par rapport au volume global de requĂŞtes dans ce type d’environnement en gĂ©nĂ©ral.

Cependant pour le point 4) quand tu dis que le XML requĂŞtĂ© par les fonctions Xpath / Xquery empĂŞche une parallĂ©lisation est ce que tu peux prĂ©ciser pourquoi .. En fait j’ai un exemple ici qui gĂ©nĂ©re un plan de requĂŞte avec parallĂ©lisation avec du XML et Xquey (testĂ© sous SQL Server 2008 avec un portable dual core) :

GO <br />

<br />

CREATE TABLE T_TEST ( <br />

ID INT IDENTITY PRIMARY KEY, <br />

ColXML XML ) <br />

GO <br />

<br />

INSERT INTO T_TEST ( ColXML ) <br />

SELECT '<Ex> <br />

<E Value="' + LTRIM( STR( RAND() * 1000 ) ) + '"/> <br />

<E Value="' + LTRIM( STR( RAND() * 1000 ) ) + '"/> <br />

</Ex>' <br />

GO 100000 <br />

<br />

SELECT <br />

ID, <br />

ColXML.value('(//E/@Value)[1]', 'float') AS Value <br />

FROM T_TEST <br />

WHERE (ColXML.exist('(//E[@Value gt 456])')= 1) <br />

GO

A+

En fait on peut faire du parallélisme en OLTP, si tout est cohérent en matière de parallélisation. Par exemple :

1) que les données de la base soit réparties sur différents fichiers situés sur des axes physiques séparés

2) que l’on ait au moins n fichiers pour la tempdb (n Ă©tant le nombre de CPU physique) et toujours sur des axes physiques sĂ©parĂ©s.

3) que les journaux de transactions soient stockés sur un agrégat RAID 10 sur 4, 6 ou 8 disques

4) que les requêtes qui portent sur des volumes important de données ne prévoient pas de point de contention qui déparallélise comme des fonctions tables ou du XML requêté par XQuery/XPath

5) que l’on limite le parallĂ©lisme Ă une valeur raisonnable (par exemple 4 CPU sur un 8 ou 12 coeurs).

6) que l’on Ă©tudie la combinaison du paramĂ©trage mode fibre et masque d’affinitĂ© en fonction du nombre et de la volumĂ©trie moyenne des requĂŞtes.

A +

Sympa.

Pourrais-tu, aussitĂ´t familiarisĂ© Ă l’outil de Nono40 pour la mise au gabarit des articles, et aussitĂ´t ton domaine activĂ©, transformer ce petit billet en un vĂ©ritable article et m’en fournir le lien ?

D’avance merci

Fadace