La première prĂ©version publique de CUDA 7.5 est disponible pour tous les dĂ©veloppeurs CUDA enregistrĂ©s auprès de NVIDIA. La principale nouveautĂ© est la gestion des nombres Ă virgule flottante codĂ©s sur seize bits, c’est-Ă -dire la moitiĂ© de l’encodage traditionnel (float sur trente-deux bits). Cette format est principalement utilisĂ©e pour du stockage de donnĂ©es quand la prĂ©cision requise n’est pas très importante, mais aussi pour des calculs sous la mĂŞme hypothèse.

Calculs sur seize bits

L’effet sur la performance du code peut ĂŞtre Ă©norme : la bande passante requise est divisĂ©e par deux, ce qui permet de transmettre deux fois plus de nombres par unitĂ© de temps sur les bus existants, d’en stocker deux fois plus sur la mĂŞme quantitĂ© de mĂ©moire. Ils pourront donc se rĂ©vĂ©ler très utiles pour les applications oĂą ces Ă©lĂ©ments sont limitatifs, comme l’apprentissage de rĂ©seaux neuronaux de grande taille ou le filtrage de signaux en temps rĂ©el.

L’avantage en temps de calcul n’est disponible que sur les GPU ayant une partie prĂ©vue pour l’arithmĂ©tique sur seize bits, ce qui n’est pas le cas pour la majoritĂ© des processeurs disponibles, sauf sur Tegra. La prochaine architecture de GPU de NVIDIA, connue sous le nom de Pascal, aura des transistors allouĂ©s pour les calculs sur seize bits : le nombre de calculs effectuĂ©s par seconde doublera entre les prĂ©cisions FP16 et FP32 (le mĂŞme rapport qu’entre FP32 et FP64). Entre temps, les calculs seront effectuĂ©s en interne sur les mĂŞmes circuits que prĂ©cĂ©demment, avec une prĂ©cision bien plus Ă©levĂ©e que des circuits dĂ©diĂ©s (bien qu’elle soit en grande partie perdue lors de l’arrondi vers les seize bits).

RĂ©seaux neuronaux

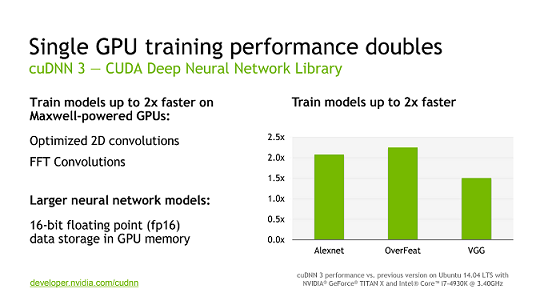

L’un des chevaux de bataille actuels de NVIDIA est l’apprentissage automatique, en particulier par rĂ©seaux neuronaux, plus spĂ©cifiquement profonds, par exemple pour une utilisation dans les voitures intelligentes. Ils ont par exemple dĂ©veloppĂ© la bibliothèque cuDNN (CUDA deep neural network), qui accĂ©lère les calculs par un GPU. La troisième version de cette bibliothèque a Ă©tĂ© optimisĂ©e, particulièrement au niveau des convolutions (FFT et 2D), ce qui amĂ©liore la performance lors de l’entraĂ®nement de rĂ©seaux neuronaux (gain d’un facteur deux pour l’apprentissage sur des GPU Maxwell). Elle gère Ă©galement les nombres en virgule flottante sur seize bits, ce qui est utile pour des rĂ©seaux très grands, mais n’amĂ©liore pas (encore) les temps de calcul.

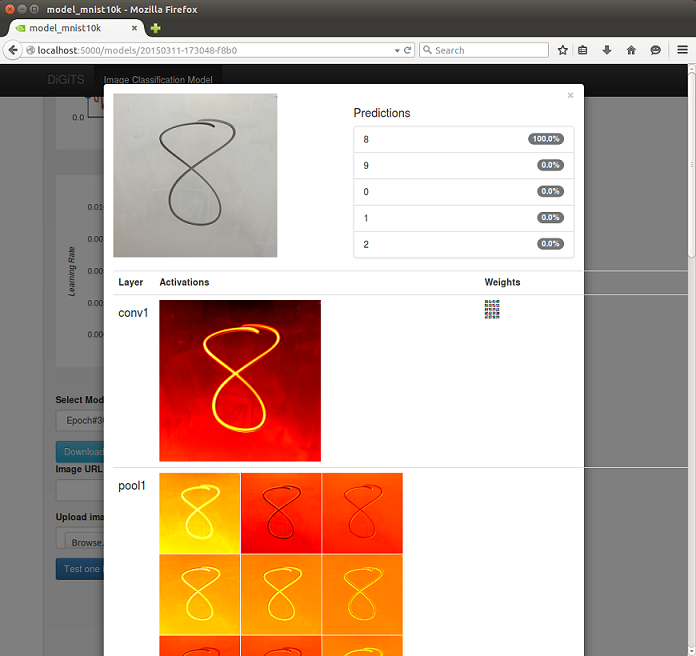

NVIDIA a aussi dĂ©veloppĂ© l’outil DIGITS, un logiciel de bien plus haut niveau que cuDNN pour les mĂŞmes rĂ©seaux neuronaux, prĂ©vu pour des profils plus scientifiques que pour des programmeurs. L’une des nouveautĂ©s est l’apprentissage distribuĂ© sur plusieurs GPU : ajouter un deuxième GPU aide Ă rĂ©duire fortement les temps de calcul (d’un facteur lĂ©gèrement infĂ©rieur Ă deux), nettement moins impressionnant en ajoutant deux autres (facteur de deux et demi). Le gain sera probablement plus important avec les prochaines architectures de GPU, Pascal devant utiliser la technologie NVLink au lieu du bus PCI Express (partagĂ©) pour la communication entre cartes.

Algèbre linéaire creuse

CUDA vient Ă©galement avec la bibliothèque cuSPARSE pour l’algèbre linĂ©aire sur des matrices creuses accĂ©lĂ©rĂ©e sur GPU. Une nouvelle opĂ©ration vient d’y ĂŞtre ajoutĂ©e, nommĂ©e GEMVI, utilisĂ©e pour la multiplication entre une matrice pleine et un vecteur creux — la sortie Ă©tant Ă©videmment un vecteur plein. Ce genre d’opĂ©rations est très utile pour l’apprentissage automatique, plus particulièrement dans le cas du traitement des langues. En effet, dans ce cas, un document rĂ©digĂ© dans une langue quelconque (français, anglais, allemand…) peut ĂŞtre reprĂ©sentĂ© comme un comptage des occurrences de mots d’un dictionnaire ; bien Ă©videmment, tous les mots du dictionnaire (mĂŞme partiel) ne sont pas prĂ©sents dans le texte, sa reprĂ©sentation vectorielle contient donc un grand nombre de zĂ©ros, il est donc creux. Une fois le dictionnaire dĂ©fini, pour amĂ©liorer l’efficacitĂ© des traitements, le dictionnaire peut ĂŞtre rĂ©duit en taille pour n’en garder qu’un sous-espace vectoriel qui prĂ©serve la sĂ©mantique des textes : la transformation de la reprĂ©sentation du texte demande justement un produit entre le vecteur creux initial et une matrice de transformation.

C++11 et fonctions anonymes

La version prĂ©cĂ©dente de CUDA a commencĂ© Ă comprendre C++11, la dernière itĂ©ration du langage de programmation. Les fonctions anonymes (lambdas) en font partie et servent notamment Ă Ă©crire du code plus concis. CUDA 7.0 ne les tolĂ©rait que dans le code exĂ©cutĂ© cĂ´tĂ© client, pas encore sur le GPU : ce point est corrigĂ©, mais seulement comme fonctionnalitĂ© expĂ©rimentale. Par exemple, un code comptant les frĂ©quences de quatre lettres dans une chaĂ®ne de caractères pourra s’Ă©crire comme ceci :

using namespace thrust;

*count = count_if(device, text, text+n, [] __device__ (char c) {

for (const auto x : { 'x','y','z','w' })

if (c == x) return true;

return false;

});

}

La mĂŞme fonctionnalitĂ© permet d’Ă©crire des boucles for pour une exĂ©cution en parallèle, avec une syntaxe similaire Ă OpenMP, par exemple une somme de deux vecteurs (SAXPY pour BLAS) :

using namespace thrust;

auto r = counting_iterator(0);

for_each(device, r, r+N, [=] __device__ (int i) {

y[i] = a * x[i] + y[i];

});

}

Profilage

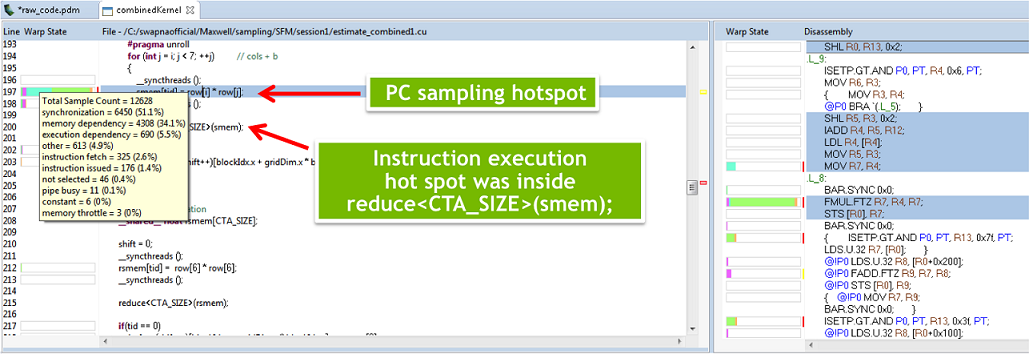

La dernière nouveautĂ© annoncĂ©e concerne le profilage de code, nĂ©cessaire pour dĂ©terminer les endroits oĂą les efforts d’amĂ©lioration de la performance doivent ĂŞtre investis en prioritĂ©. CUDA 7.5 amĂ©liore les outils NVIDIA Visual Profiler et NSight Eclipse Edition en proposant un profilage au niveau de l’instruction PTX (uniquement sur les GPU Maxwell GM200 et plus rĂ©cents), pour dĂ©termines les lignes prĂ©cises dans le code qui causent un ralentissement. PrĂ©cĂ©demment, le profilage ne pouvait se faire qu’au niveau d’un noyau, Ă©quivalent d’une fonction pour la programmation sur GPU (temps pris par le noyau Ă l’exĂ©cution, importance relative par rapport Ă l’exĂ©cution complète).

CUDA 6 avait dĂ©jĂ amĂ©liorĂ© la situation en affichant une corrĂ©lation entre les lignes de code et le nombre d’instructions correspondantes. Cependant, un grand nombre d’instructions n’indique pas forcĂ©ment que le noyau correspondant prendra beaucoup de temps Ă l’exĂ©cution. Pour remonter jusqu’Ă la source du problème, ces informations sont certes utiles, mais pas suffisantes, Ă moins d’avoir une grande expĂ©rience. Grâce Ă CUDA 7.5, le profilage se fait de manière beaucoup plus traditionnelle, avec un Ă©chantillonnage de l’exĂ©cution du programme, pour trouver les lignes qui prennent le plus de temps.

Sources et crédit des images : New Features in CUDA 7.5, NVIDIA @ ICML 2015: CUDA 7.5, cuDNN 3, & DIGITS 2 Announced.