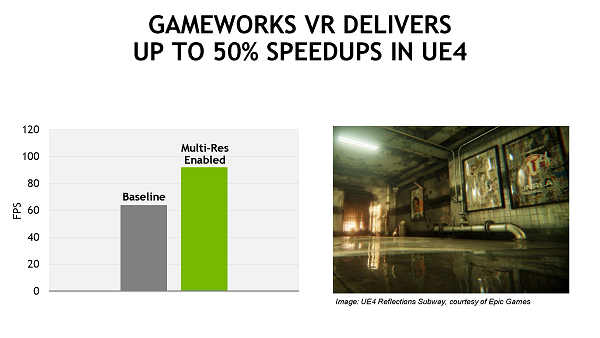

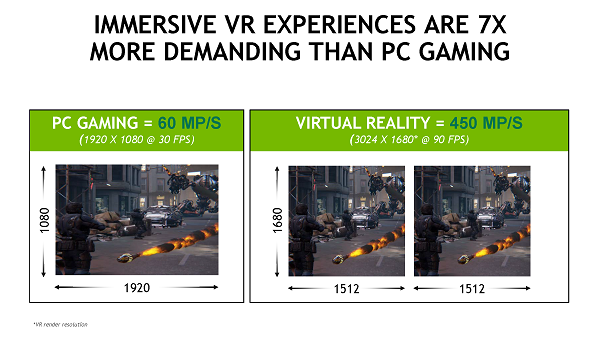

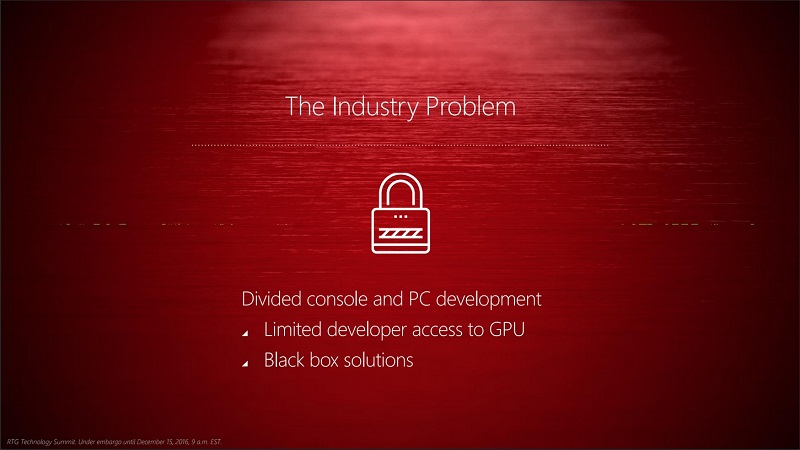

Depuis quelques annĂ©es, NVIDIA a lancĂ© sa suite de bibliothèques logicielles baptisĂ©e GameWorks. Elles sont spĂ©cifiquement prĂ©vues pour le jeu vidĂ©o et donnent la possibilitĂ© aux dĂ©veloppeurs d’intĂ©grer aisĂ©ment des effets, comme la simulation de poils en tout genre avec HairWorks ou encore d’herbe avec Turf Effects. La famille compte aussi GameWorks VR, qui promet d’importants gains en performance pour les jeux exploitant la rĂ©alitĂ© virtuelle.

NVIDIA met en avant l’optimisation effectuĂ©e sur ces implĂ©mentations et la facilitĂ© d’intĂ©gration, ce qui dĂ©charge les studios d’une bonne partie du travail… sauf qu’il semblerait que l’optimisation peut se faire au dĂ©triment d’AMD. L’exemple de Witcher 3 a montrĂ© que HairWorks exploitait un point fort du matĂ©riel vendu par NVIDIA, la tesselation — ce qui nuisait fortement Ă la performance sur les cartes AMD.

Une stratĂ©gie : l’ouverture

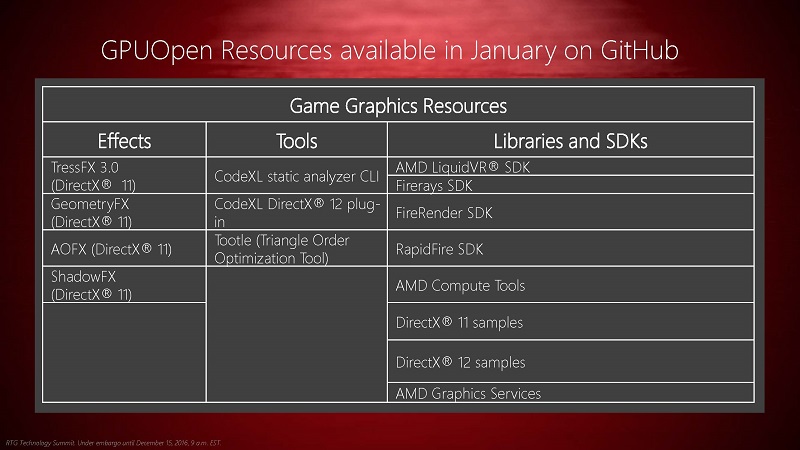

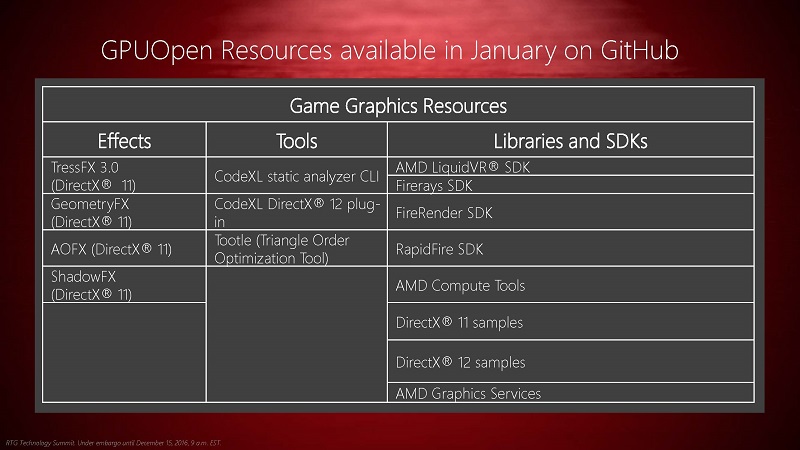

Justement, AMD prĂ©pare sa rĂ©ponse Ă GameWorks sous le nom de GPUOpen, en arrĂŞtant de se focaliser sur l’aspect matĂ©riel du jeu vidĂ©o. La diffĂ©rence principale par rapport Ă GameWorks est la licence du code : lĂ oĂą les bibliothèques GameWorks sont disponibles gratuitement après enregistrement, sous une licence propriĂ©taire peu restrictive (les sources sont disponibles sur demande sous licence), AMD envisage de proposer ses bibliothèques GPUOpen comme logiciels libres, sous licence MIT, distribuĂ©s sur GitHub, dès janvier. Rien n’indique cependant que le dĂ©veloppement aura bien lieu sur GitHub et que les contributions seront facilement acceptĂ©es (y compris les optimisations pour le matĂ©riel autre que celui d’AMD).

Cet Ă©lĂ©ment n’est pas le premier de la stratĂ©gie actuelle de AMD. Peu auparavant, ils avaient annoncĂ© une couche de compatibilitĂ© avec CUDA, la technologie propriĂ©taire de calcul sur processeur graphique de NVIDIA. AMD a aussi lancĂ© une nouvelle version de leurs pilotes pour carte graphique, dĂ©nommĂ©e Radeon Software Crimson Edition, qui a apportĂ© un tout nouveau panneau de configuration, bien plus pratique Ă l’usage que le prĂ©cĂ©dent, ainsi qu’une performance amĂ©liorĂ©e pour les jeux (bien qu’invisible sous Linux). Globalement, AMD essaye de rattraper son retard par rapport Ă ses concurrents du cĂ´tĂ© PC — malgrĂ© son omniprĂ©sence sur le marchĂ© des consoles.

Du contenu pour les jeux…

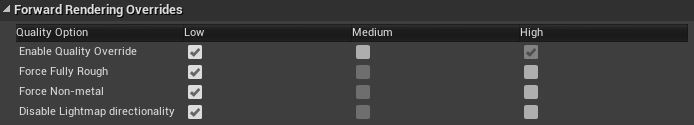

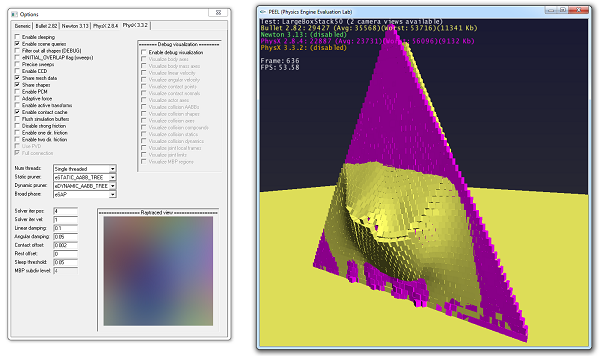

Dans les bibliothèques disponibles, une bonne partie du contenu sera tout Ă fait nouveau. Il y aura bien sĂ»r TressFX, sa solution de simulation de cheveux, poils et brins d’herbe, dans la version 3.0. Elle Ă©tait dĂ©jĂ disponible gratuitement, sources comprises, sur le site d’AMD — un mĂ©canisme moins facile d’accès que GitHub. Également, AMD devrait rendre disponibles en janvier les bibliothèques GeometryFX (opĂ©rations gĂ©omĂ©triques ou simulation physique, selon les sources), ShadowFX pour les ombres et AOFX pour l’occultation ambiante. AMD inclura ses exemples de code, tant pour DirectX 11 et 12 qu’OpenGL.

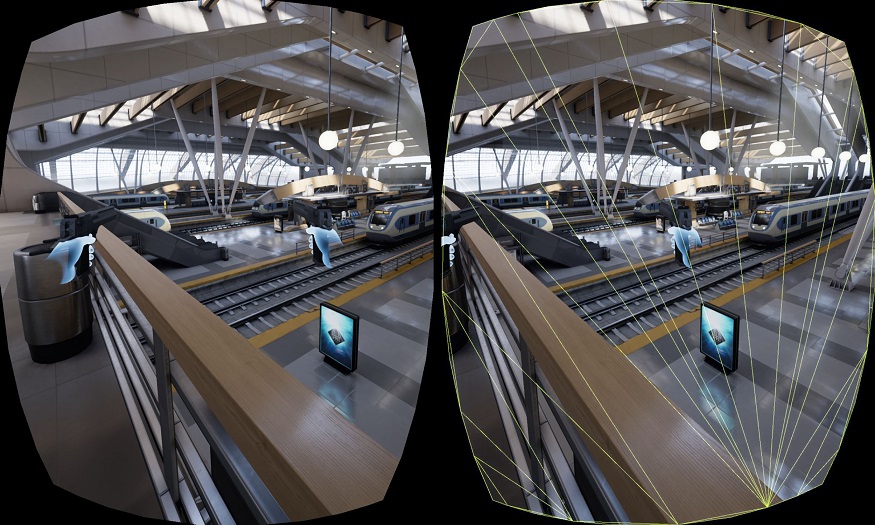

Les bibliothèques proposĂ©es ne devraient pas seulement s’Ă©tendre du cĂ´tĂ© des effets pour des jeux vidĂ©o, avec notamment LiquidVR pour la rĂ©alitĂ© virtuelle, le moteur de rendu par lancer de rayons FireRender et la bibliothèque de lancer de rayons FireRays, RapidFire pour le dĂ©ploiement dans le nuage. Pour faciliter le dĂ©veloppement, AMD devrait aussi fournir CodeXL pour l’analyse statique de code (y compris pour DirectX 12) et Tootle pour le prĂ©traitement des maillages des modèles 3D Ă afficher afin d’amĂ©liorer la performance au rendu (mĂŞme si le dĂ©veloppement de cet outil a officiellement cessĂ© en 2010).

… mais pas seulement !

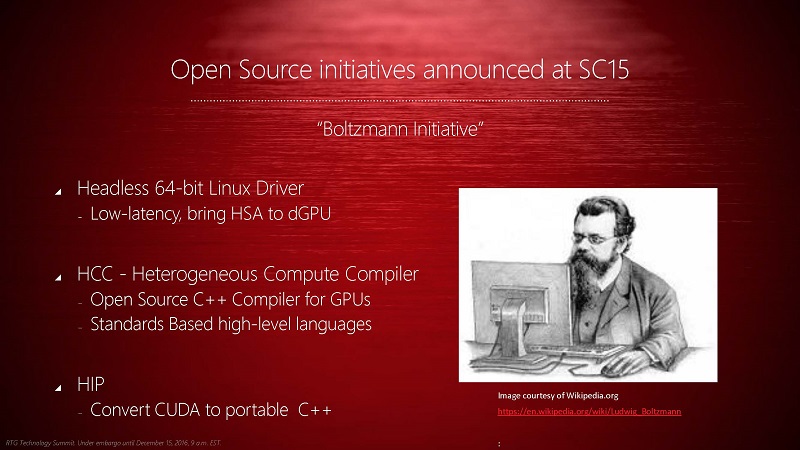

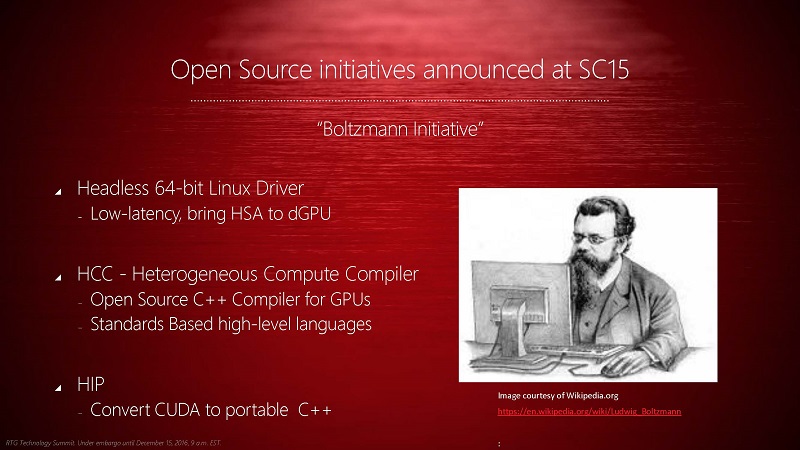

GPUOpen ne profitera pas seulement au secteur du jeu vidĂ©o, mais aussi pour le calcul de haute performance, l’initiative Boltzmann Ă©tant incluse sous ce nom, avec un nouveau compilateur HCC, un pilote pour Linux spĂ©cifiquement optimisĂ© pour le calcul sur GPU ou encore HIP pour la compatibilitĂ© avec CUDA.

Ils participent aussi au projet Caffe, actif dans le domaine de l’apprentissage profond (technique notamment utilisĂ©e avec succès dans la vision par ordinateur), pour lequel ils optimisent une version OpenCL (sans indiquer d’avantage en performance par rapport Ă cuDNN, l’option de NVIDIA).

Du libre aussi pour Linux

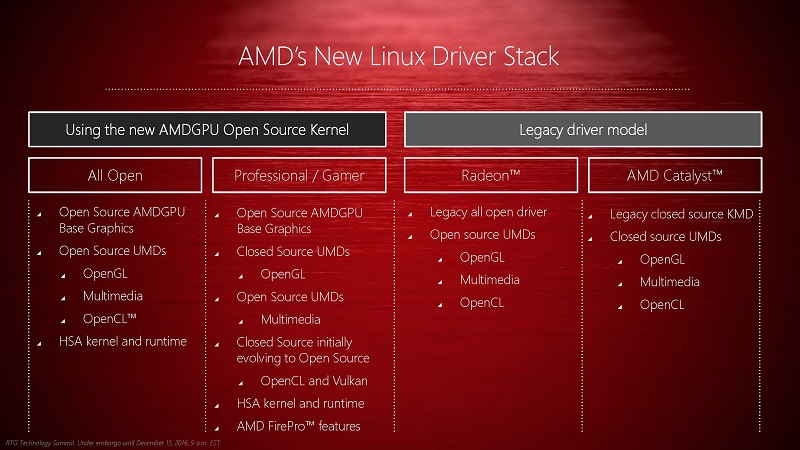

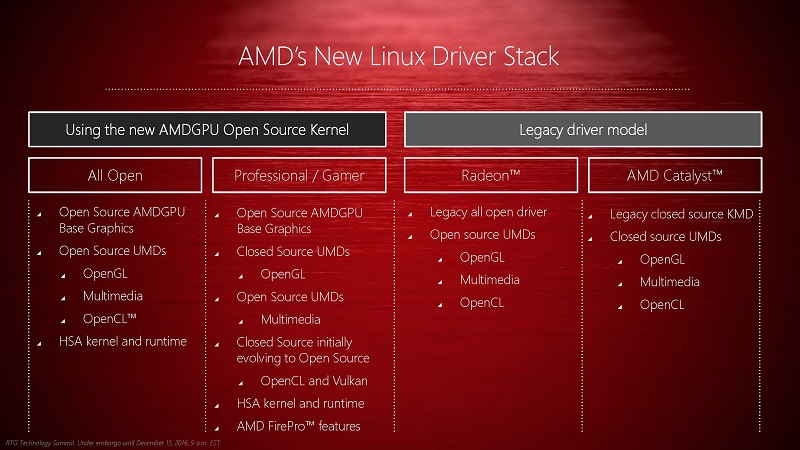

Le dernier point mis en avant par AMD pour ce projet GPUOpen est la mise en place effective de leur architecture de pilote libre pour leurs cartes graphiques. La performance des pilotes actuellement fournis par AMD n’est pas optimale pour tous les types d’utilisation, Ă©tant parfois largement dĂ©passĂ©s par l’implĂ©mentation complètement libre Radeon — les deux Ă©tant souvent dĂ©crits comme largement en deçà des attentes, notamment pour les machines Steam.

La nouvelle architecture, dĂ©jĂ annoncĂ©e l’annĂ©e dernière, s’articule autour d’une partie libre — AMDGPU —, directement incluse dans le noyau Linux. Cette partie n’aura aucune implĂ©mentation des piles graphiques telles que OpenGL ou Vulkan — totalement inutiles dans les applications de calcul pur.

Ensuite, les implĂ©mentations libre et propriĂ©taire pourront diverger pour tout ce qui concerne OpenGL, l’accĂ©lĂ©ration du dĂ©codage de vidĂ©os, OpenCL et HSA. L’implĂ©mentation propriĂ©taire d’OpenCL et de Vulkan devrait ĂŞtre distribuĂ©e en libre dans le futur, un mouvement qui n’est pas encore prĂ©vu pour OpenGL. Les fonctionnalitĂ©s spĂ©cifiques aux cartes professionnelles FirePro seront, bien Ă©videmment, uniquement propriĂ©taires, mĂŞme si rien n’empĂŞche l’implĂ©mentation libre de les fournir.

Ces supplĂ©ments au pilote noyau fonctionneront entièrement en espace utilisateur, ce qui devrait amĂ©liorer la sĂ©curitĂ© de l’implĂ©mentation et diminuer le nombre de changements de contexte utilisateur-noyau.

Sources : prĂ©sentation d’AMD, Direkte Kontrolle der Radeon-Hardware fĂĽr Spieleentwickler, AMD Further Embraces Open Source with GPUOpen, for Games and Compute, AMD embraces open source to take on Nvidia’s GameWorks.

Merci Ă Claude Leloup pour ses corrections.