Un petit billet sur un compteur que vous connaissez certainement tous et qui permet en autre de dĂ©tecter une pression mĂ©moire sur une instance SQL Server. Seulement en faisant un audit des compteurs de surveillance d’un de mes clients, je me suis aperçu qu’il n’utilisait que ce dernier pour dĂ©tecter la prĂ©sence ou non une pression mĂ©moire sur l’ensemble des instances de son parc. Je lui ai donc expliquĂ© que l’utilisation unique de ce compteur ne permettait pas Ă tous les coups de dĂ©tecter un problème d’utilisation mĂ©moire. Je vous propose de voir pourquoi dans ce billet.

Tout d’abord commençons par regarder la dĂ©finition de cet compteur :

« Percentage of pages found in the buffer cache without having to read from disk. The ratio is the total number of cache hits divided by the total number of cache lookups over the last few thousand page accesses. After a long period of time, the ratio moves very little. Because reading from the cache is much less expensive than reading from disk, you want this ratio to be high. Generally, you can increase the buffer cache hit ratio by increasing the amount of memory available to SQL Server. »

Ce compteur reprĂ©sente donc le pourcentage de pages qui seront satisfaites directement depuis le cache de donnĂ©es SQL Server sans avoir Ă les rĂ©cupĂ©rer sur disque. On peut donc facilement comprendre que la diminution de ce ratio peut signifier qu’il existe un problème potentiel de pression mĂ©moire puisque les accès aux pages de donnĂ©es seront feront d’abord sur disque et ensuite dans le cache de donnĂ©es. Si ce compteur est directement reprĂ©sentatif d’un problème de mĂ©moire alors pourquoi la surveillance unique de ce dernier ne suffit-elle pas ? Pour rĂ©pondre Ă cette question faisons un test :

CrĂ©ons une base de donnĂ©es avec une table ayant une volumĂ©trie supĂ©rieure Ă la taille du cache allouĂ© Ă SQL Server pour garantir que SQL Server devra effectuer des lectures physiques pour rĂ©cupĂ©rer les pages de donnĂ©es nĂ©cessaires Ă nos requĂŞtes. Si l’on suit la dĂ©finition de notre compteur Buffer Cache Hit Ratio nous devrions voir une diminution du ration pendant notre test. J’ai limitĂ© volontairement la taille du cache de donnĂ©es Ă 1Go et j’ai crĂ©Ă© une table avec une taille lĂ©gèrement supĂ©rieure Ă 3Go.

EXEC sp_configure N’show advanced options’ , N’1′

RECONFIGURE WITH OVERRIDE

GO

EXEC sp_configure N’max server memory (MB)’ , N’1024′

GO

RECONFIGURE WITH OVERRIDE

GO

CREATE DATABASE test_buffer_cache_hit_ratio;

GOUSE test_buffer_cache_hit_ratio;

GOCREATE TABLE dbo.test

(

id INT IDENTITY(1,1),

col1 CHAR(1000),

col2 CHAR(1000),

col3 CHAR(1000)

);

GOINSERT dbo.test (col1, col2, col3) VALUES (REPLICATE(‘T’, 1000), REPLICATE(‘T’, 1000), REPLICATE(‘T’, 1000))

GO 818998

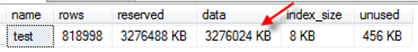

VĂ©rifions la taille de notre table :

EXEC sp_spaceused ‘dbo.test';

GO

qui donne une table de 3199 Mo :

Â

Pendant notre test je vous propose d’ajouter d’autres compteurs qui nous seront utiles pour dĂ©montrer que l’utilisation unique du compteur BCHR n’est pas judicieuse.

- Page Life Expectancy : qui reprĂ©senta la durĂ©e de vie en seconde d’une page dans le cache de donnĂ©es SQL Server sans ĂŞtre rĂ©fĂ©rencĂ©e

- Page reads/sec : qui représente le nombre de lectures physique par seconde effectuée par SQL Server. Il faut comprendre ici que la ou les pages concernés ne sont pas lues depuis le cache de données. Autant dire que cette valeur doit être la plus petite possible.

- Free pages : qui reprĂ©sente le nombre de pages libres disponible pour une allocation immĂ©diate dans le cache de donnĂ©esÂ

J’ai Ă©galement rajoutĂ© un compteur liĂ© Ă l’utilisation des disques Ă savoir :

- Disks Read/sec : qui reprĂ©sente le nombre d’IO en lecture par seconde

Â

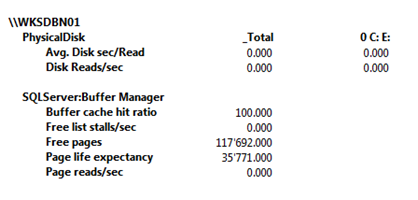

D’autres compteurs sont prĂ©sents dans la dĂ©monstration mais seuls ceux citĂ©s plus haut nous servirons dans le cadre du prĂ©sent billet. La situation primaire est la suivante :

Une situation plutĂ´t pĂ©renne avec un BCHR de 100%, une durĂ©e de vie de page dans le cache 596 minutes et un nombre consĂ©quent de pages libres dans le buffer. Pour lancer nos requĂŞtes j’utiliserai un outil plutĂ´t sympathique pour notre exercice : SQLQueryStress.

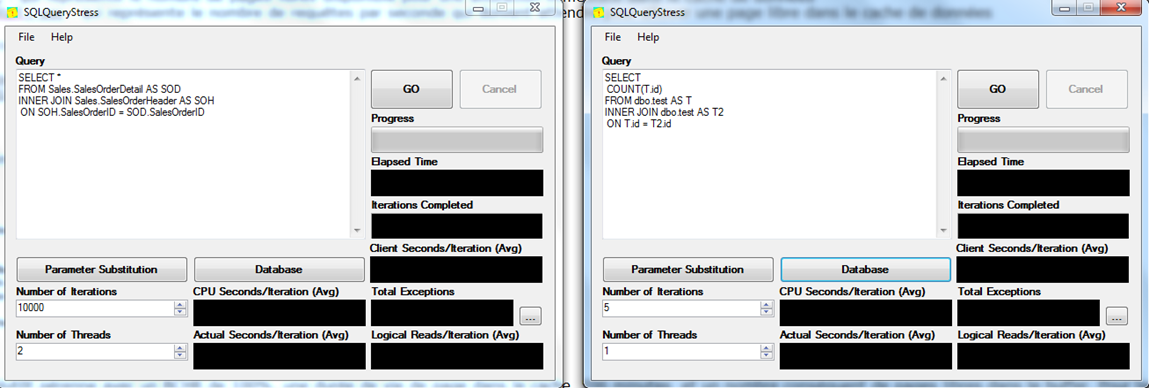

![]() 1ère phase : Avec SQLQueryStress je lance une requĂŞte sans impact majeure (sur la base AdventureWorks) sur le cache avec suffisamment d’itĂ©ration (10000) pour que celle puisse durer le temps de notre test. Au prĂ©alable j’aurai vidĂ© le cache de donnĂ©es SQL Server.

1ère phase : Avec SQLQueryStress je lance une requĂŞte sans impact majeure (sur la base AdventureWorks) sur le cache avec suffisamment d’itĂ©ration (10000) pour que celle puisse durer le temps de notre test. Au prĂ©alable j’aurai vidĂ© le cache de donnĂ©es SQL Server.

![]() 2ème phase : Je lance une seconde requête qui va venir remplir notre cache de données en interrogeant les données de notre table dbo.test précédemment créé.

2ème phase : Je lance une seconde requête qui va venir remplir notre cache de données en interrogeant les données de notre table dbo.test précédemment créé.

Â

Â

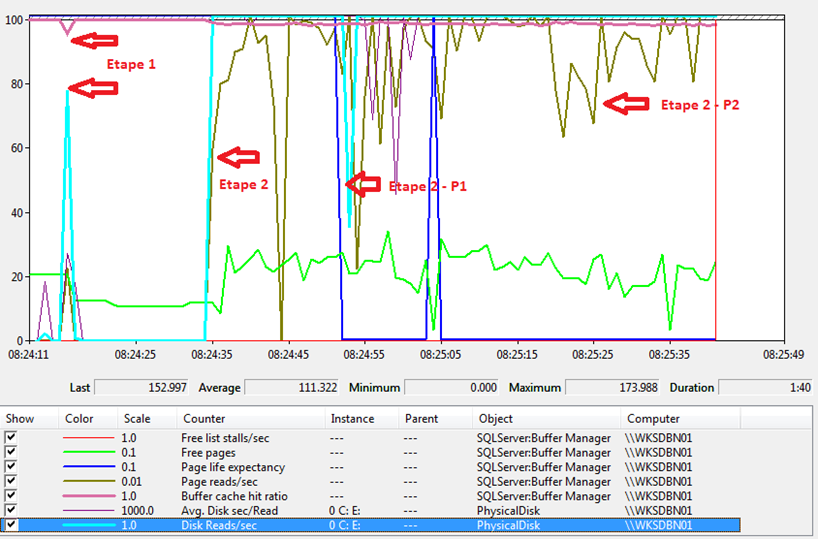

et voici les résultats :

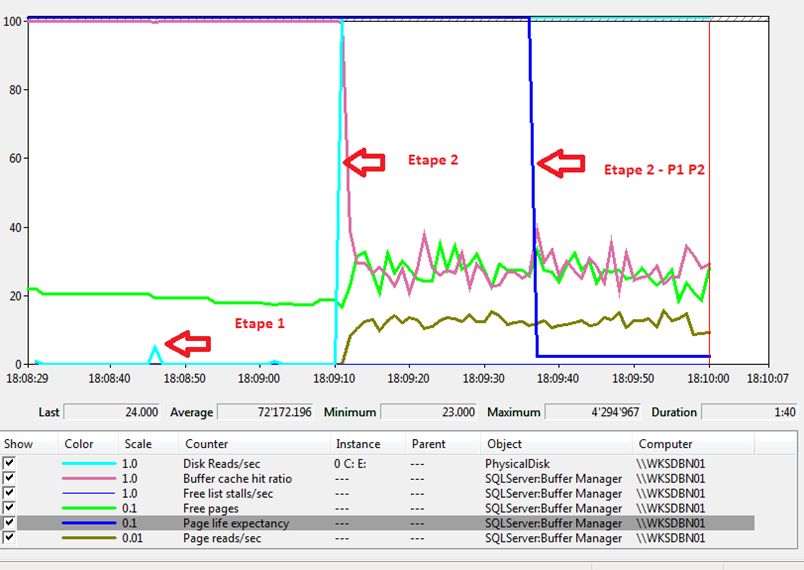

Un peu d’explication est nĂ©cessaire parmi tout ces lignes de monitoring. A l’Ă©tape 1 on voit un pic de diminution du buffer cache hit ratio associĂ© Ă une montĂ©e soudaine des lectures de pages sur disque. Cette première phase est tout Ă fait normal car ayant vider le cache des donnĂ©es au prĂ©alable SQL Server est obligĂ© d’aller chercher la première fois les donnĂ©es sur disque. On constate d’ailleurs que la valeur du cache hit ratio se stabilise par la suite et qu’aucune lecture des pages n’est faite sur disque.

A l’Ă©tape 2 j’augmente la charge en exĂ©cutant la 2ème requĂŞte qui interroge notre fameuse table dbo.test. On constate presque instantanĂ©ment que le nombre de lectures disques augmente (compteurs Disk Read/sec et Page read/sec). En revanche on se ne voit pas de changement radical de valeur pour le BCHR.

A l’Ă©tape 2 – P1, la durĂ©e de vie d’une page dans le cache de donnĂ©es chute drastiquement. En effet, comme la table dbo.test ne tient pas en mĂ©moire SQL Server est obligĂ© de vider les pages du cache de donnĂ©es pour satisfaire l’exĂ©cution simultanĂ©e de nos 2 requĂŞtes. Mais encore une fois on ne voit aucun changement au niveau du BCHR.

A l’Ă©tape 2 – P2 on constate que les lectures sur disque sont nombreuses, que l’espĂ©rance de vie d’une page dans le cache des donnĂ©es est proche de zĂ©ro mais que le BCHR est toujours proche de 100%

On vient donc ici de dĂ©montrer que la lecture seule du BCHR n’est pas suffisante pour dĂ©tecter une pression mĂ©moire. Alors la question est pourquoi ? O_O … O_O … Tout simplement parce que nous avons oubliĂ© que SQL Server Ă©tait capable de faire de la lecture anticipĂ©e et que celle-ci va donc lire plus de donnĂ©es que nĂ©cessaire pour tenter de satisfaire la lecture des prochaines donnĂ©es qui seront du coup dĂ©jĂ en cache. Comme nous l’avons vu un peu plus haute la valeur du BCHR dĂ©termine le taux d’accès de pages de donnĂ©es dĂ©jĂ en cache par rapport Ă ceux effectuĂ©s sur disque. C’est le cas ici car la lecture anticipĂ©e permet comme son nom l’indique d’anticiper les prochaines lectures de pages dans le cache de donnĂ©es. C’est la raison pour laquelle la valeur de compteur ne bouge pratiquement pas ici. Sans cette lecture anticipĂ©e on aurait une valeur de compteur beaucoup plus variable. Peut-on le prouver ? Bien sĂ»r. Pour cela il suffit de dĂ©sactiver l’utilisation de la lecture anticipĂ©e sur notre instance SQL Server en activant le trace flag 652.

DBCC TRACEON(652, -1);

GO

On réalise à nouveau les mêmes tests que précédemment et voici le résultat :

A l’Ă©tape 1 on retrouve la mĂŞme chose que tout Ă l’heure. Le cache Ă©tant vide au dĂ©part une première lecture des donnĂ©es de la première requĂŞte donne lieu Ă des accès sur disque pour remonter les pages dans le cache des donnĂ©es SQL Server.

A l’Ă©tape 2 on lance notre requĂŞte de sĂ©lection sur la table dbo.test. Ici c’est une tout autre histoire. On voit que le nombre de lectures physiques augmente comme tout Ă l’heure mais que la valeur du BCHR diminue drastiquement Ă©galement. En effet, la lecture anticipĂ©e n’est plus lĂ pour satisfaire les prochaine lectures de pages directement dans le cache de donnĂ©es. Du coup on se retrouve Ă aller chercher plus souvent les pages de donnĂ©es sur disque que dans le cache de donnĂ©es.

A l’Ă©tape 2 – P1 P2 on retrouve la mĂŞme situation que tout Ă l’heure. L’espĂ©rance de vie d’une page de donnĂ©es chute puisque SQL Server est obligĂ© de vider le cache au fur et Ă mesure pour remonter les nouvelles pages qui devront ĂŞtre accĂ©dĂ©es pendant l’exĂ©cution de nos 2 requĂŞtes.

Â

Nous avons donc vu que la valeur du BHCR ne permettait pas Ă elle seule de dĂ©tecter une pression mĂ©moire sur une instance SQL Server. Je dirai mĂŞme que lorsque la valeur de ce compteur commence Ă chuter plus que de raison il est dĂ©jĂ trop tard. Maintenant il est question ici d’environnements OLTP comme vous l’avez sans doute deviner. Il n’est pas rare de voir la valeur de compteur beaucoup plus basse dans des environnements OLAP avec des entrepĂ´ts de donnĂ©es. J’espère en tout cas que ce billet vous aura convaincu de ne pas utiliser uniquement la valeur du BCHR dans vos outils de monitoring.

Bonne surveillance !!

David BARBARIN (Mikedavem)

MVP SQL Server

Nice one thx

thx

Excellente explication, merci Ă toi