L’Unreal Engine nouveau est arrivĂ©, trois mois après le prĂ©cĂ©dent, comme d’habitude. LĂ oĂą la version prĂ©cĂ©dente se concentrait sur la rĂ©alitĂ© virtuelle, la version 4.13 s’Ă©parpille plus, mĂŞme si l’Ă©diteur en rĂ©alitĂ© virtuelle est toujours l’objet d’une grande attention. Parmi les domaines d’amĂ©liorations, on compte cette fois le rendu et l’Ă©diteur de cinĂ©matiques, mĂŞme s’il est impossible de citer toutes les nouveautĂ©s en peu de mots.

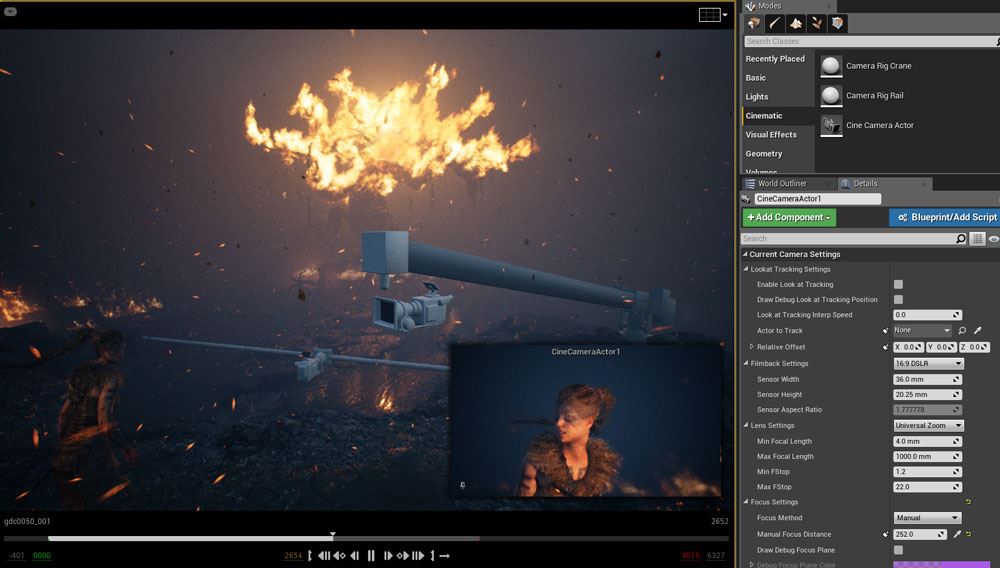

Éditeur de cinématiques Sequencer

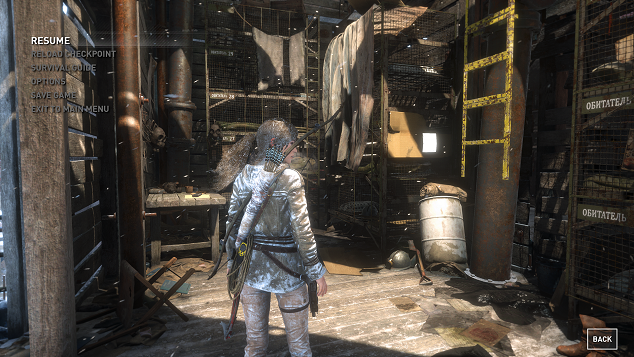

L’Ă©diteur non linĂ©aire de cinĂ©matiques apparu dans la 4.12 reste le théâtre d’opĂ©rations d’envergure, avec la possibilitĂ© d’enregistrer en direct une partie dans le jeu dĂ©veloppĂ©. Cette capture n’est pas une vidĂ©o : au contraire, toutes les animations, tous les effets, tous les sons sont mĂ©morisĂ©s sĂ©parĂ©ment et peuvent ĂŞtre modifiĂ©s dans l’Ă©diteur ! Au moment de cette capture, il est aussi possible de limiter l’enregistrement Ă une sĂ©rie de composants et de propriĂ©tĂ©s.

Rendu

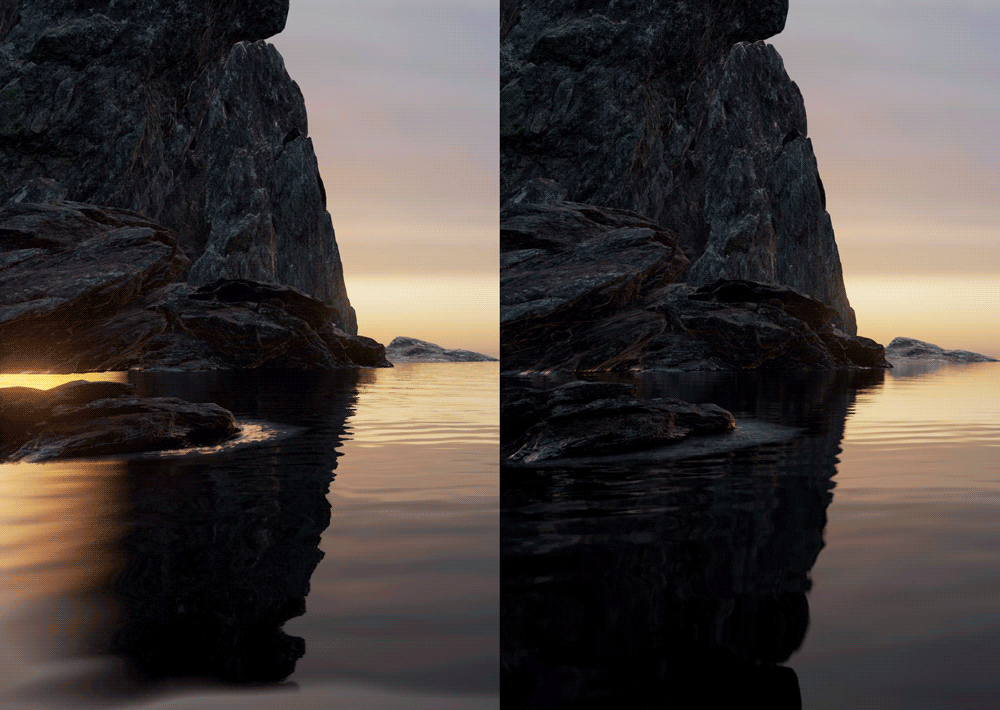

Du cĂ´tĂ© du rendu 3D, les lampes ont vu leur code optimisĂ© : si une lumière ne se dĂ©place pas dans la scène, une bonne partie des calculs dĂ©jĂ effectuĂ©s peuvent ĂŞtre rĂ©utilisĂ©s sans problème pour la prochaine image Ă afficher. Le problème de performance vient surtout du calcul des ombres que crĂ©e la lumière (plus prĂ©cisĂ©ment, de la carte des profondeurs). Cette optimisation est appliquĂ©e automatiquement et ses rĂ©sultats sont intĂ©ressants : pour afficher l’image ci-dessous, avec trente-trois points de lumière, il faut compter 14,89 ms pour l’affichage des ombres ; grâce aux caches implĂ©mentĂ©s, la mĂŞme partie prend 0,9 ms d’affichage, ce qui permet d’ajouter d’autres effets (il faut cependant compter deux millisecondes pour l’affichage de la lumière, une contribution qui n’est pas touchĂ©e par cette optimisation).

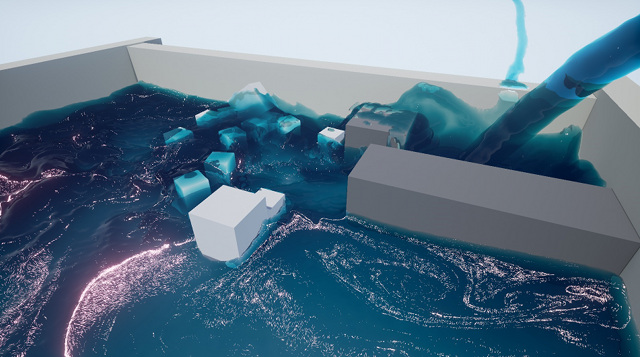

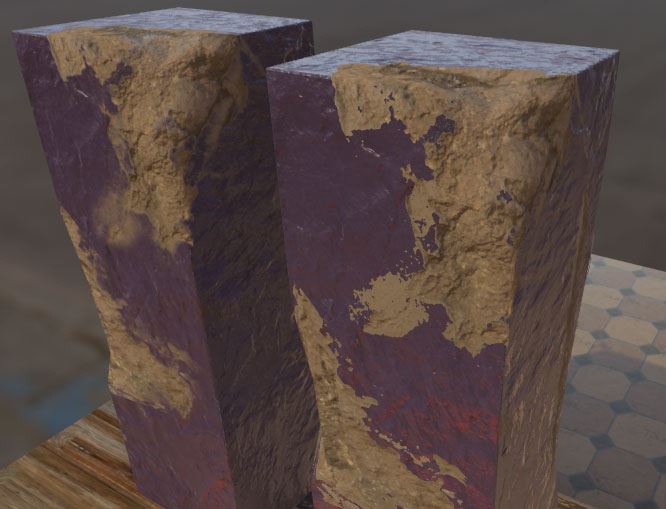

Unreal Engine permet de gĂ©nĂ©rer des matĂ©riaux de manière alĂ©atoire grâce Ă des fonctions de bruit. La famille d’algorithmes disponibles s’est agrandie pour recevoir le bruit de VoronoĂŻ, très souvent utilisĂ© pour la gĂ©nĂ©ration procĂ©durale. Il s’applique notamment très bien Ă la gĂ©nĂ©ration de marbre, le rendu Ă©tant très rĂ©aliste après un peu de configuration.

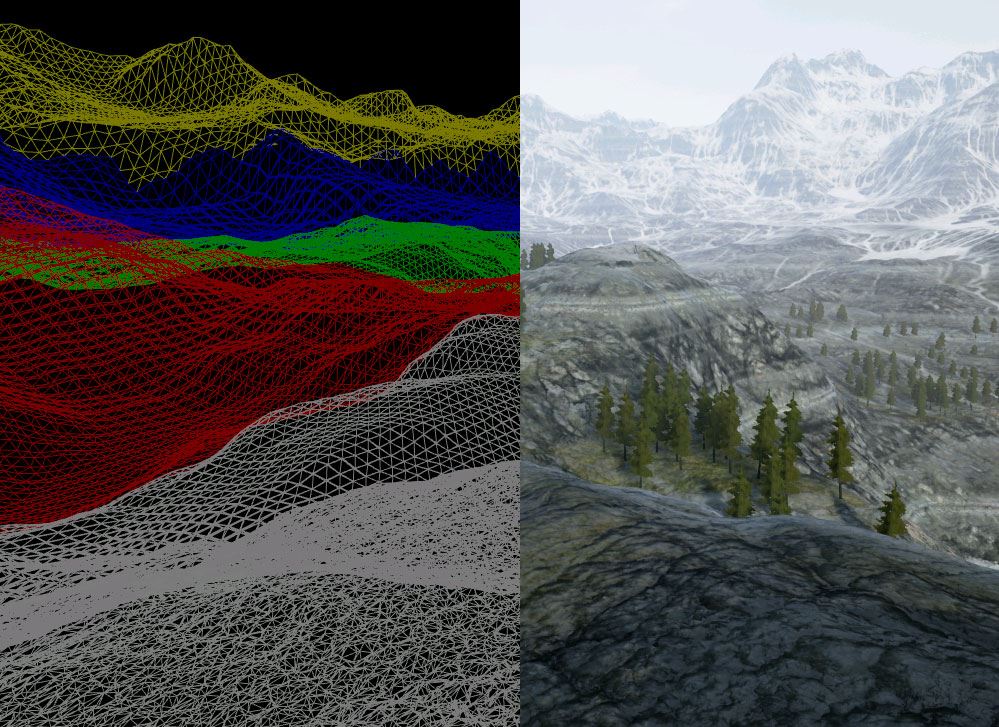

Il devient possible de superposer des couches de matériaux sur une topologie statique, ce qui peut avoir un effet de lissage entre les différents calques, sans utiliser de projection.

L’interaction avec des composants d’interface graphique intĂ©grĂ©s dans le monde peut se faire avec n’importe quel pointeur laser (pas simplement directement avec la souris). L’action ainsi gĂ©nĂ©rĂ©e simule celle que pourrait avoir un composant matĂ©riel : un clic gauche ou droit… ou toute autre interaction. Cette amĂ©lioration vient en support Ă celles de l’Ă©diteur en rĂ©alitĂ© virtuelle (voir plus bas).

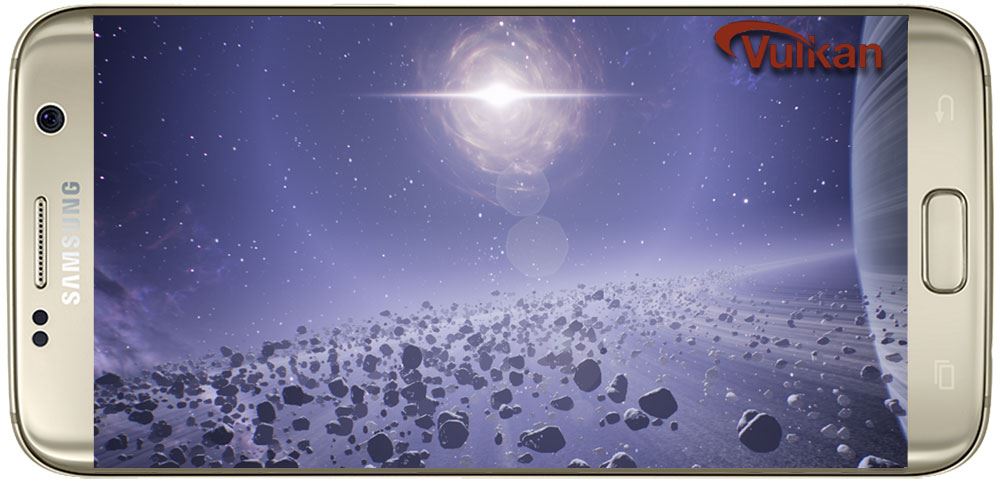

Les applications mobiles pourront utiliser des effets de type posttraitement, par exemple comme si l’image venait d’une vieille tĂ©lĂ©vision. Ces effets ne peuvent pas encore exploiter toutes les informations disponibles pour le rendu (la profondeur de chaque pixel n’est pas encore accessible), mais cela devrait venir avec une version ultĂ©rieure. Ces effets ne sont pas disponibles sur les versions les plus ancestrales d’Android.

Les applications mobiles pourront utiliser des effets de type posttraitement, par exemple comme si l’image venait d’une vieille tĂ©lĂ©vision. Ces effets ne peuvent pas encore exploiter toutes les informations disponibles pour le rendu (la profondeur de chaque pixel n’est pas encore accessible), mais cela devrait venir avec une version ultĂ©rieure. Ces effets ne sont pas disponibles sur les versions les plus ancestrales d’Android.

Les opĂ©rations de pavage des paysages sont maintenant bien plus rapides qu’avant, l’accĂ©lĂ©ration matĂ©rielle Ă©tant mieux utilisĂ©e : cette technique de rendu n’est utilisĂ©e que pour les plus hauts niveaux de dĂ©tail, elle ne l’est plus du tout pour les plus faibles (comme des zones lointaines).

Éditeur en réalité virtuelle

Le nouvel Ă©diteur en rĂ©alitĂ© virtuelle, apparu pour la 4.12, est toujours l’objet d’une grande attention. Il devient possible de peindre sur des textures existantes, par exemple.

Il permet aussi de peindre rapidement une sĂ©rie d’arbres, en sĂ©lectionnant simplement le type de feuillage Ă crĂ©er.

Bien Ă©videmment, cette nouvelle version vient avec bien d’autres nouvelles fonctionnalitĂ©s et optimisations, dĂ©crites dans les notes de version.

Source et images : UNREAL ENGINE 4.13 RELEASED!.