mars

2012

Le moteur de recherche a annoncé sur son blog pour les webmasters, une amélioration des fonctionnalités de son outil d’analyse d’exploration pour les webmasters.

Ainsi, Google offre une interface plus épurée et nous offre maintenant trois parties :

- Les erreurs au niveau du site

- Les erreurs au niveau des URL

- Les 1 000 premières pages comportant des erreurs

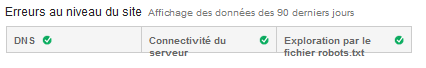

Les erreurs au niveau du site

Comme vous pouvez le constater, nous avons un rapide quant au trois différent points et au statut de ces derniers.

Lors d’erreur rencontrée concernant ces points, un point d’exclamation rouge apparait avec un lien renvoyant vers des informations quant au problème ou aux problèmes rencontrés.

Un histogramme montrera l’évolution de la pérennité de votre plateforme comme ci-dessous.

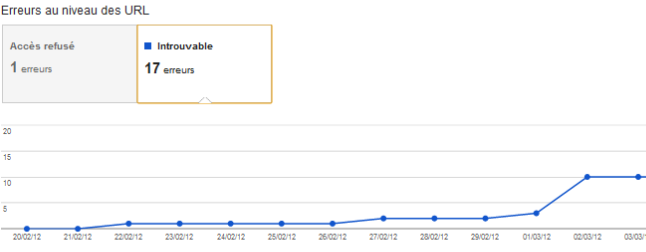

Les erreurs au niveau des URL

Un bandeau affichant les problèmes rencontrés au travers des URLs.

Nous pouvons constater que le site dispose d’un accès refusé au robot et de 17 éléments non trouvés.

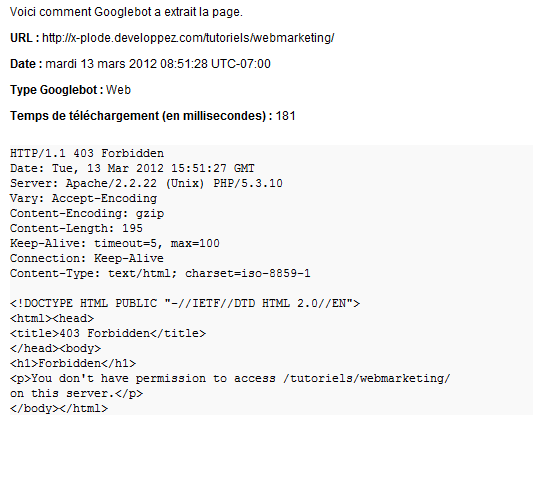

Avec la nouvelle interface, il est plus simple d’investiguer et de trouver la cause de l’erreur afficher.

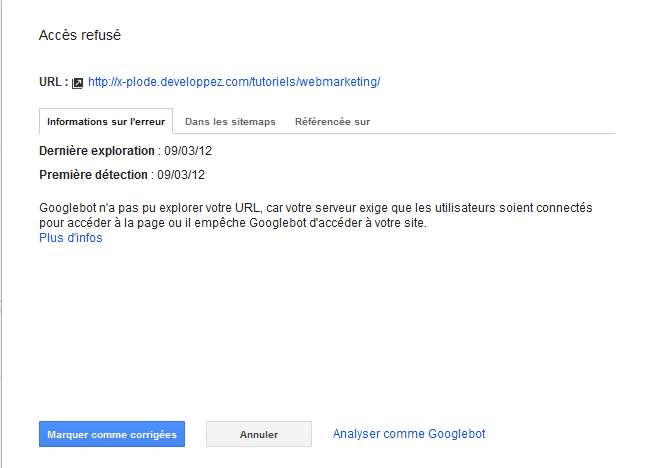

Ainsi pour le problème évoqué d’accès, nous disposons d’un lien afin d’en connaitre plus sur le sujet.

Une popin s’ouvre et nous affiche des logs concernant le problème :

Tout autant, nous pouvons pousser notre analyse plus loin en retentant de parcourir le site comme Googlebot le fait par une simple action dans l’administration.

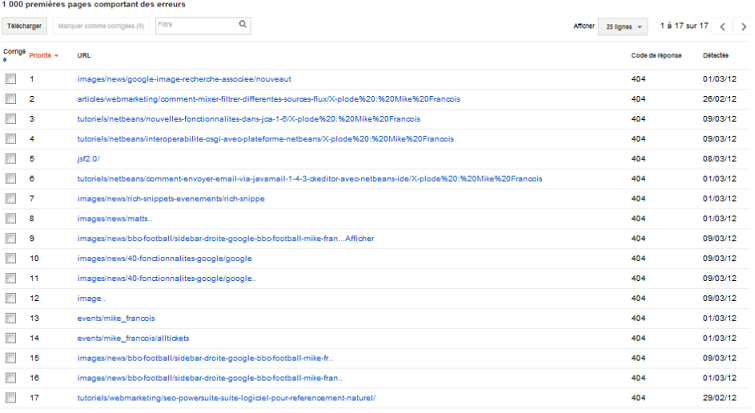

Les 1000 premières pages comportant des erreurs

Et enfin, une vue des statistiques d’erreurs du site.

Nous disposons des différentes URLs avec leurs codes de réponse.

Tout autant, nous pouvons télécharger le listing des différentes adresses ayant soulevé un problème ( limité à 1000 lignes… Less is more selon Google ).

Toutes ses choses apportent un lot de nouveauté pour les webmasters souhaitant connaitre les problèmes que le moteur rencontre à chaque passe de son robot sur leurs sites internet.

Néanmoins, certaines personnes voient plutôt une régression dans cette mise à jour qu’une amélioration.

C’est le cas pour Vanessa Fox qui liste un nombre certain de fonctionnalités utiles modifiée ou supprimée.

Ainsi, elle fait part de :

- La régression du nombre de téléchargement maximum de 100 000 à 1 000 URLs pour chacun des types d’erreur.

- La possibilité de télécharger tout le contenu des sources de l’erreur à disparu.

- Les erreurs de redirection font place au numéro du code de réponse comme 302…

- Le rapport contenant les URLs bloquées par le fichier robot.txt à disparu ( mais les webmasters pourraient retrouver dans quelque temps des informations similaires dans la section d’accès du robot d’exploration ).

Articles récents

- Nouvelle du jour : ce blog reprend vie :)

- Google acquiert les brevets applicatifs de Cuil

- 12 Méthodes d’analyse des liens qui auraient pu changer au sein de Google en février 2012

- Nouveautés chez Google dans les outils pour les webmasters

- Google fait un rappel important sur le prestataire pour l’hébergement de votre site internet

Commentaires récents

- dans Pourquoi Oracle devrait continuer à aider Netbeans ?

- dans Soirée GlassFish & Groovy à l’INSA avec le JUG de Lyon

- dans Une annonce de James Gosling (le créateur de Java) pour les membres de Developpez.com

- dans Une annonce de James Gosling (le créateur de Java) pour les membres de Developpez.com

- dans Session : Monitoring and Troubleshooting Glassfish application server in the wild

Un article de X-plode

Un article de X-plode