La « scalabilitûˋ » (en franûÏais l’extensibilitûˋ voire « croissance » pour certains auteurs) d’un serveur est sa propension û pourvoir augmenter les ressources physiques de l’ensemble du systû´me de faûÏon û faire face û une charge accrue ou bien permettre une rûˋpartition de charge. Par exemple en matiû´re de serveur web, ajouter des machines en parallû´le permet rapidement et û peu de frais d’augmenter la surface d’attaque globale du systû´me. Il n’en va pas de mûˆme en matiû´re de serveur de bases de donnûˋes, du fait des donnûˋes ! Petites explications…

La « scalabilitûˋ » (en anglais scalability) rûˋpond en fait û la problûˋmatique de montûˋe en charge, mais pas de tolûˋrance û la panne (haute disponibilitûˋ), bien qu’il soit dans un certains nombre de cas possible de faire les deux.

Sa dûˋfinition prûˋcise est la suivcante :

Aptitude d’un systû´me û maintenir un mûˆme niveau de performance face û l’augmentation de charge ou de volumûˋtrie, par augmentation des ressources matûˋrielle et sans impact global sur le systû´me (par exemple sans nûˋcessitûˋ de modifier les applications hûˋbergûˋes par les machines).

1 – les deux voies de la « scalabilitûˋ »

Il existe deux maniû´re de rûˋaliser une extension û un systû´me existant : la scalabilitûˋ horizontale (dite externe) et la scalabilitûˋ verticale (dite interne).

La scalabilitûˋ horizontale consiste û rajouter en parallû´le des machines supplûˋmentaires. C’est pourquoi on parle de croissance externe. On part d’une machine et on rajoute au fur et û mesure de l’augmentation de la charge de nouvelles machines identiques.

Avantages :

- On ne paye que les machine au fur et û mesure.

- La panne d’une machine ne pûˋnalise pas le systû´me (tolûˋrance û la panne)

- Le systû´me est globalement plus flexible

- La mise û jour sans interruption de service est possible

Inconvûˋnients :

- Il faut trouver un moyen de rûˋpartir les demandes (une application particuliû´re doit gûˋrer la rûˋpartition de charge en envoyant la demande au serveur le moins occupûˋ û l’instant t).

- Il faut payer des licences pour chaque machine

- Lãadministration de n serveur consomme n fois plus de temps (sauf û disposer d’un outil spûˋcifique de gestion multi serveur…)

- sur le long terme des machines identiques ne sont plus commercialisûˋes.

Avant mise en place du « scale out » (croissance externe….) :

Aprû´s mise en place du « scale out » :

La scalabilitûˋ verticale consiste û rajouter des ressources supplûˋmentaire û la machine (CPU, RAM, disque carte rûˋseau…). C’est pourquoi on parle de croissance interne. On part d’une machine conûÏue pour ûˋvoluer et on rajoute au fur et û mesure de l’augmentation de la charge des ressources spûˋcifiques.

Avantages :

- Aucun outil de rûˋpartition de charge n’est û ajouter.

- Une seule licence û payer.

- Une administration simplifiûˋe et moins couteuse.

- Mûˆme si sur le long terme les ressources matûˋrielle peuvent devenir obsolû´te, il est plus facile de transfûˋrer un seul serveur qu’une multitude.

Inconvûˋnients :

- Il n’y a pas de tolûˋrance û la panne

- On paye cher la machine de dûˋpart.

- Le systû´me est moins flexible

- La mise û jour sans interruption de service n’est pas possible

Avant mise en place du « scale up » (croissance interne) :

Aprû´s mise en place du « scale up » :

… et encore plus longtemps aprû´s :

2 – Scale Up, Scale Out… quelles diffûˋrences ?

Au fond on pourrait croire que les deux techniques sont interchangeables… Il n’en est rien. En effet la diffûˋrence essentielle tient û lãexistence (ou bien û lãabsence) de tout ce qui constitue les ûˋlûˋments û partager. Dans un environnement multiprocessus, un espace mûˋmoire partagûˋ peut ûˆtre utilisûˋ et adressûˋ par tous. Dans un environnement distribuûˋ, il en va tout autrement. Il faut trouver le moyen de synchroniser la prûˋsence des ûˋlûˋments û partager sur chacune des machines. Il y a donc nûˋcessitûˋ de rajouter un mûˋcanisme de communication entre les diffûˋrentes machines et plus on tend vers la prûˋsence synchrone des ûˋlûˋments partagûˋs, plus ce mûˋcanisme devient couteux.

Prenons pas exemple le cas du site web « passif », c’est û dire sans tenir compte des donnûˋes dynamiques qui pourrait figurer dans une base. Si l’on met û jour le code et les fichiers dudit site web une fois par jour, un simple FTP permettrais d’envoyer û toutes les machines les nouveaux ûˋlûˋments partagûˋs. Ceci est donc totalement asynchrone et û faible frûˋquence. Pour l’utilisateur authentifiûˋ il en va tout autrement. Il faut trouver un moyen pour informer tous les serveurs de l’ûˋtat dans lequel se trouve sa connexion. Certes le volume des donnûˋes û communiquer n’est pas trû´s important mais multiplier par le nombre de serveur, cela peut ûˋcrouler û terme le systû´me !

Prenons maintenant le cas de la base de donnûˋes qui effectuerais par exemple 1000 transactions par minutes, concernant chacune environ 2 Ko de donnûˋes. Rûˋpartissons lû sur 10 serveur, c’est dûˋjû 300 Ko par seconde de communications û envoyer entre les diffûˋrentes machines. De plus il faut gûˋrer l’intûˋgritûˋ des donnûˋes, la cohûˋrence et la disponibilitûˋ (par exemple telle donnûˋe sur tel serveur est actuellement verrouillûˋe par une autre transactions). Le systû´me devient alors vite incapable de prendre en charge un tel trafic et s’ûˋcroule trû´s rapidement !

Enfin, et du fait de la charge induite par le a communication entre les néuds, le gain entre scale-up et scale-out nãest pas linûˋaire. Ainsi en en passant du scale-up au scale-out, on observe une baisse significative des temps de rûˋponse, car soudainement ce néud doit gûˋrer le rûˋseau, les transactions, la duplication des donnûˋes, toutes tûÂches qui incombaient auparavant û la seule machine et qui ûˋtait traitûˋe de maniû´re interne.

Mais il existe un moyen de rûˋduire ce coû£t, en concevant son application de maniû´re distribuûˋe. Pour une application, ce sera par exemple û base de services. Pour une base de donnûˋes, ce sera û l’aide des mûˋcanismes spûˋcifique du serveur (RAC pour Oracle ou Service Broker pour MS SQL Server) tant est si bien qu’il faudra sans doute rûˋûˋcrire entiû´rement lãapplication puisque le modû´le de programmation diffû´re radicalement entre les 2 modes.

3 – Rûˋsumons…

De maniû´re gûˋnûˋral, les SGBDR ne peuvent que difficilement reproduire les mûˋcanismes de rûˋpartition de charge des serveurs Web, et cela pour une raison toute simple : il faudrait que les donnûˋes soient simultanûˋment prûˋsente sur tous les serveur. Autrement dit une insertion d’une ligne dans une table doit ûˆtre envoyûˋ û tous les serveurs. C’est pourquoi il est fortement dûˋconseillûˋ dans la plupart des cas de faire du scale out pour les SDGBR ! Il faut donc veiller dû´s le dûˋpart û acheter un serveur fortement ûˋvolutif…

Quelques rûˋfûˋrences :

Scalabilitûˋ, le choix des armes

Scalabilitûˋ verticale ou scalabilitûˋ horizontale ?

PS : j’ai empruntûˋ quelques phrases a ce dernier et excellent article qui prûˋsente clairement les choses.

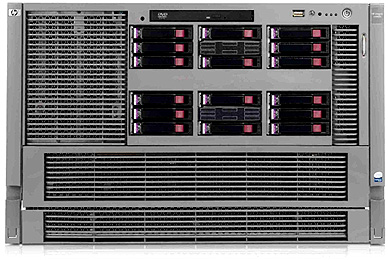

Photos : serveurs HP

--------

Frûˋdûˋric Brouard, SQLpro - ARCHITECTE DE DONNûES, http://sqlpro.developpez.com/

Expert bases de donnûˋes relationnelles et langage SQL. MVP Microsoft SQL Server

www.sqlspot.com : modûˋlisation, conseil, audit, optimisation, tuning, formation

* * * * * Enseignant CNAM PACA - ISEN Toulon - CESI Aix en Provence * * * * *

Oui, car les entrepûÇts de donnûˋes ne sont pas par nature transactionnel. On les alimente soit par « scrath and go », soit par diffûˋrence dans un laps de temps dûˋterminûˋ. Par exemple une journûˋe. Donc il est possible de les saucissonner !

Sur les environnements fortement transactionnels le scale out me parait compliquûˋ en effet. La notion de NLB des serveurs IIS par exemple est difficilement reproductible sur un serveur de bases de donnûˋes. Cependant il y a des scûˋnarios oû¿ le scale out est intûˋressant comme par exemple les entrepûÇts donnûˋes. Ainsi on peut profiter de l’ensemble des ressources serveurs û disposition.

++