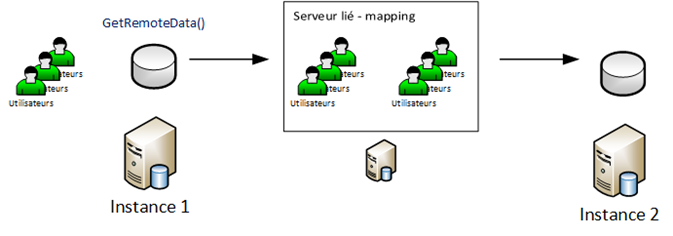

Lorsqu’on crĂ©e un groupe de disponibilitĂ© avec SQL Server et AlwaysOn on l’associe par la suite Ă un listener. Lorsque ce dernier est crĂ©Ă© plusieurs objets lui sont associĂ©es :

- Un objet d’ordinateur dans l’annuaire active directory

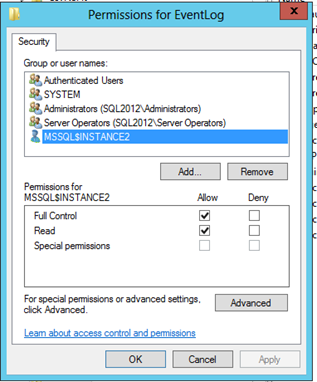

- Une entrée DNS de type A

- Une ressource cluster associée à au groupe de ressource créé et qui représente le groupe de disponibilité

Dans l’exemple suivante un groupe de disponibilitĂ© nommĂ© AdventureWorks2 a Ă©tĂ© crĂ©Ă©. Le listener associĂ© s’appelle LST_ADVW2

![]() Les différents objets associés

Les différents objets associés

L’objet d’ordinateur dans l’annuaire :

… l’enregistrement DNS :

… Le groupe de ressource liĂ© au groupe de disponibilitĂ© :

… et les ressources qui le composent :

Jetons un coup d’Ĺ“il aux dĂ©pendances existantes entre les ressources du groupe de ressource AdventureWorksGrp2 :

Ici on vient bien les dĂ©pendances existantes : le groupe de disponibilitĂ© AdventureWorksGrp2 dĂ©pend de la ressource "nom rĂ©seau" qui reprĂ©sente notre listener (LST_ADVW2) qui elle mĂŞme dĂ©pend de la ressource "Adresse IP" qui vous l’aurez devinez, correspond Ă l’adresse IP de notre listener.

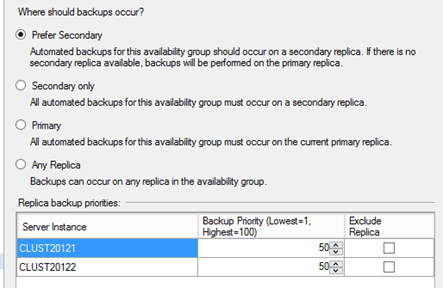

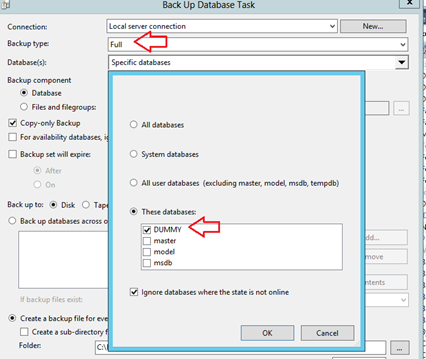

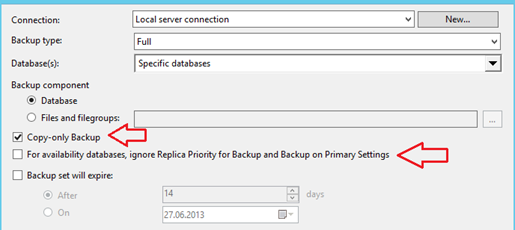

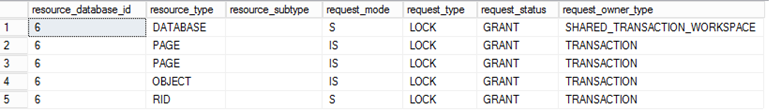

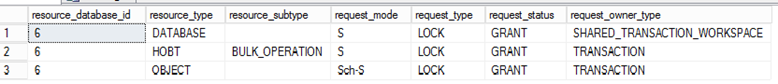

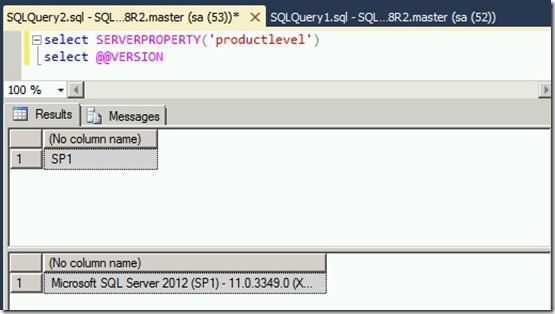

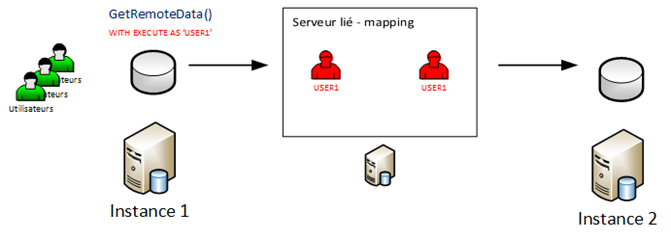

Est-ce qu’un listener doit Ă©couter sur le mĂŞme port que les rĂ©plicas du groupe disponibilitĂ© ? Est-ce possible ? C’est une question qui s’est posĂ© rapidement dans mon cas lorsqu’il a fallu installer des rĂ©plicas n’Ă©coutant pas sur le port qui n’Ă©coutaient pas sur le port par dĂ©faut (1433). On peut mĂŞme aller Ă l’extrĂŞme et prendre le cas oĂą chaque rĂ©plica Ă©coute sur un port diffĂ©rent. Dans ce cas quel port dois-je paramĂ©trer pour mon listener ? Un listener peut tout Ă fait Ă©couter sur un port diffĂ©rent que les rĂ©plicas. Le choix du numĂ©ro de port dĂ©pend Ă©videment de vos besoins, contraintes de sĂ©curitĂ© etc … Prenons un exemple avec 2 rĂ©plicas qui Ă©coutent sur 2 ports diffĂ©rents (1499 et 1500) et un listener qui Ă©coute sur le port 1433.

[AlwaysOn Instance]

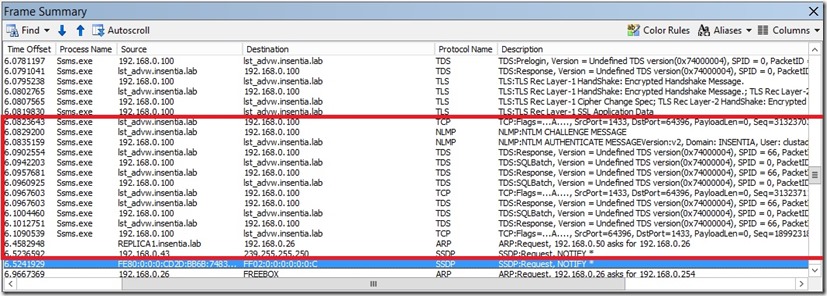

Cette configuration fonctionne parfaitement. Par curiosité on peut voir ce que cela donne sur une trace réseau via NetMon par exemple.

On peut voir ici une connexion depuis SQL Server Management Studio vers le listener lst_advw.insentia.lab (IP virtuelle : 192.168.0.61)

Dans notre cas le listener Ă©coute sur le port 1433 et la connexion est automatiquement redirigĂ©e vers le rĂ©plica concernĂ© en toute transparence. Au niveau de la chaine de connexion l’impact est minime : le nom du listener remplace tout simple le nom de l’instance SQL Server. Cependant que se passe-t-il maintenant si nous changeons le port d’Ă©coute du listener vers un port non standard ? En rĂ©alitĂ© les choses se compliquent un peu et il existe plusieurs cas :

- On spécifie le numéro de port directement dans la chaine de connexion

- On a la possibilitĂ© d’utiliser le format suivant : [nom listener]\[nom instance] sous certaines conditions :

- On utilise des instances nommĂ©es qui portent le mĂŞme nom pour l’ensemble des rĂ©plicas

- Le service SQL Browser est dĂ©marrĂ© et opĂ©rationnel sur l’ensemble des rĂ©plicas pour effectuer la rĂ©solution de nom de l’instance vers le numĂ©ro de port adĂ©quat.

![]() Cas de la redirection vers un réplica secondaire en lecture seule

Cas de la redirection vers un réplica secondaire en lecture seule

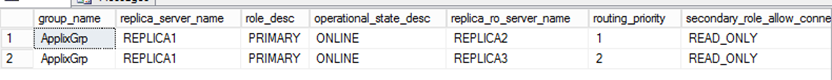

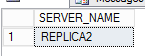

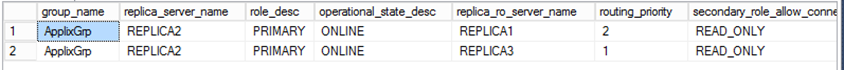

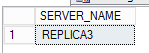

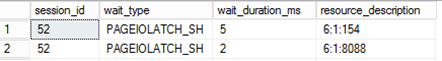

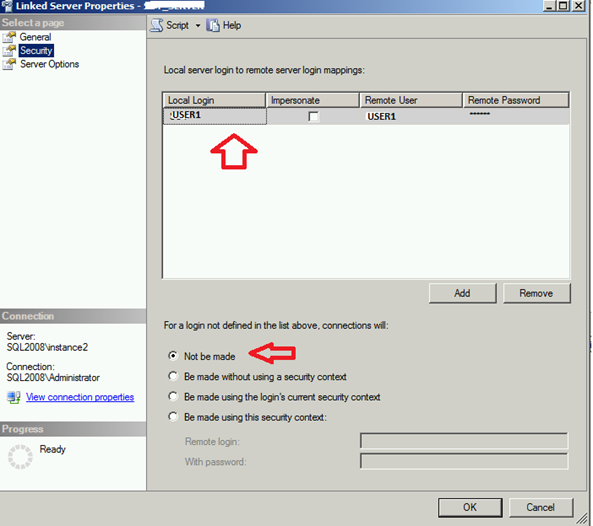

AlwaysOn nous fournit la possibilitĂ© d’ĂŞtre redirigĂ© vers un rĂ©plica secondaire en lecture seule en se connectant via le listener Ă condition que les règles de redirection aient Ă©tĂ© dĂ©finies (routes et prioritĂ©s). Dans ce cas une trace NetMon nous rĂ©vèle la chose suivante :

On peut constater ici qu’après la phase d’authentification la connexion de SQL Server Management Studio initialement effectuĂ©e vers le listener lst_advw.insentia.lab (port 1433) est redirigĂ© vers le rĂ©plica secondaire en lecture seule REPLICA2 (port 1498)

![]() Kerberos, SPN et redirection vers un réplica secondaire en lecture seule

Kerberos, SPN et redirection vers un réplica secondaire en lecture seule

La documentation en ligne Microsoft stipule que pour utiliser Kerberos dans une architecture AlwaysOn il faut ajouter les SPN correspondants Ă nos listeners. Cependant je n’ai pas trouvĂ© dans la documentation le cas oĂą le listener effectuait une redirection d’une connexion en lecture seule vers un rĂ©plica secondaire en lecture seule. Dans ce cas ajouter les SPN pour les listeners ne suffit pas et l’on doit Ă©galement ajouter les rĂ©plicas secondaires en lecture seule.

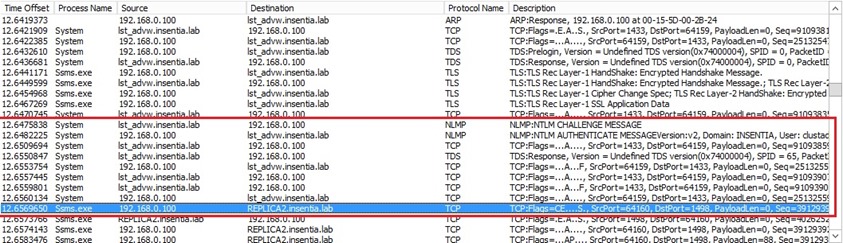

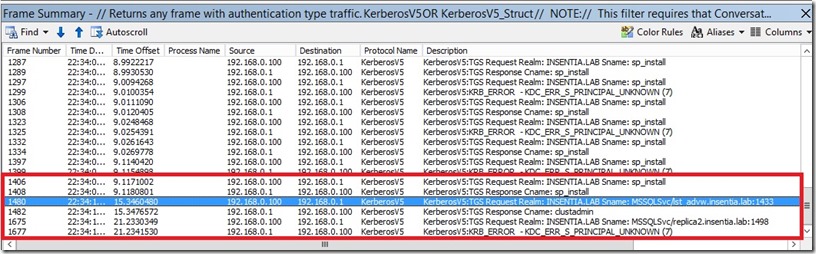

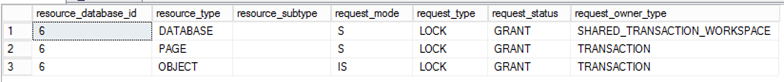

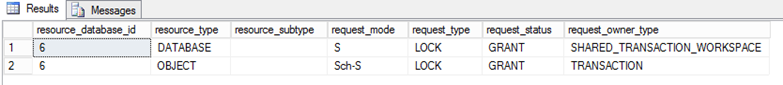

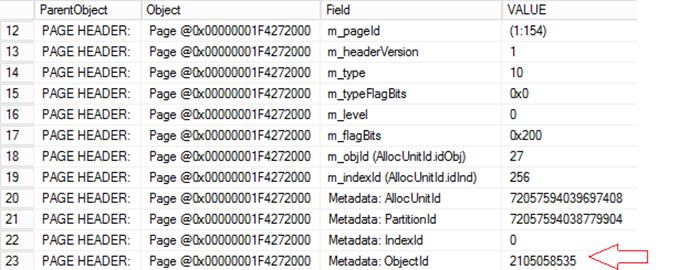

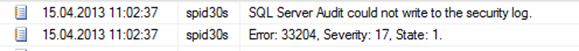

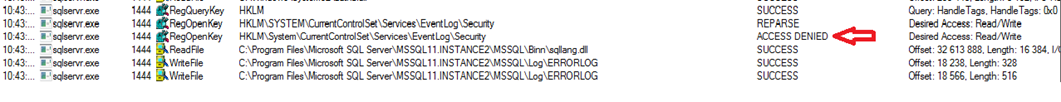

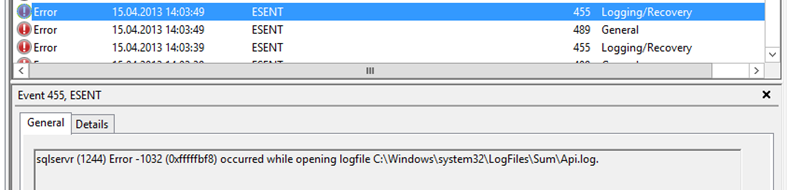

Voici une trace netmon d’une tentative de connexion en erreur Ă un rĂ©plica secondaire avec Kerberos :

On peut voir ici 2 requĂŞtes TGS depuis ma station cliente (192.168.0.100) vers mon contrĂ´leur de domaine (192.168.0.1) :

- TGS request vers le service MSSQLSvc/lst_advw.insentia.lab (port 1433) : listener

- TGS request vers le service MSSQLSvc/replica2.insentia.lab (port 1498) : réplica secondaire en lecture seule

Le contrĂ´leur de domaine rĂ©pond avec une erreur pour la deuxième demande car il n’y a pas de SPN paramĂ©trĂ© pour REPLICA2 dans mon cas (KDC_ERR_S_PRINCIPAL_UNKNOW)

![]() Listeners vs alias (DNS / SQL) ?

Listeners vs alias (DNS / SQL) ?

Une question intĂ©ressante surtout lorsqu’on a l’habitude de lier le point de connexion des applications via un alias DNS ou SQL par exemple. Ainsi lorsqu’on change de serveur de bases de donnĂ©es avec un nouveau nom, il suffit d’utiliser de modifier l’alias en consĂ©quence. Le changement est donc relativement transparent pour les applications. Avec SQL Server AlwaysOn, lorsqu’un un listener est crĂ©Ă© nous avons vu qu’une entrĂ©e DNS est Ă©galement effectuĂ©e. De plus on a la possibilitĂ© d’associer plusieurs listeners Ă un seul groupe de disponibilitĂ© ce qui peut tout Ă fait remplacer les alias. Bien entendu chaque mĂ©thode prĂ©sente des avantages mais aussi des inconvĂ©nients. Goden Yao (Program Manager , SQL Server Engine High Availability) a Ă©crit un billet intĂ©ressant Ă ce sujet.

Bon paramétrage de listeners !!

David BARBARIN (Mikedavem)

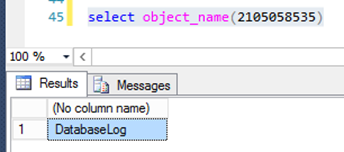

MVP SQL Server