Chez un de mes clients on est venu me dire la chose suivante : visiblement lorsque j’utilise le hint NOLOCK ou un niveau de transaction READ UNCOMMITED lorsque j’exĂ©cute une requĂŞte je vois quand mĂŞme des verrous posĂ©s sur mes tables alors que je croyais le contraire et du coup ma requĂŞte en lecture doit bloquer les mises Ă jour … A cela j’ai rĂ©pondu : la vĂ©ritĂ© est ailleurs ![]()

Plus sĂ©rieusement, la bonne question Ă se poser est la suivante : est-ce que le fait d’utiliser un hint NOLOCK ou un niveau de transaction permettant la lecture sale veut dire que aucun verrou n’est posĂ© ?

Pour répondre prenons un exemple simple avec une requête dans la base de données AdventureWorksDW2012 :

FROM dbo.FactInternetSales AS f

CROSS JOIN dbo.FactInternetSales AS f2

Voyons les verrous posĂ©es par cette requĂŞte Ă l’aide de la DMV sys.dm_tran_locks :

resource_database_id,

resource_type,

resource_subtype,

request_mode,

request_type,

request_status,

request_owner_type

FROM sys.dm_tran_locks

WHERE request_session_id = "session"

…

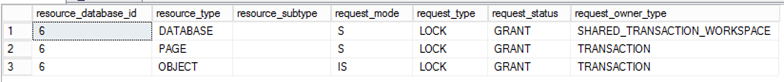

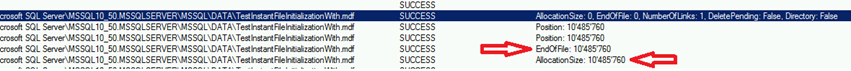

![]() Avec un niveau d’isolation de transaction en read committed (niveau d’isolation par dĂ©faut) :

Avec un niveau d’isolation de transaction en read committed (niveau d’isolation par dĂ©faut) :

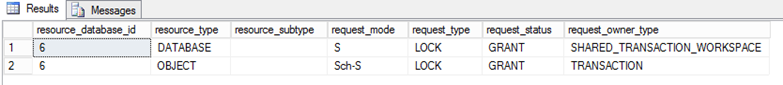

![]() Avec un niveau d’isolation de transaction en read uncommitted :

Avec un niveau d’isolation de transaction en read uncommitted :

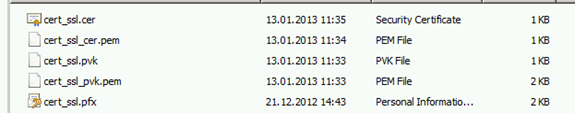

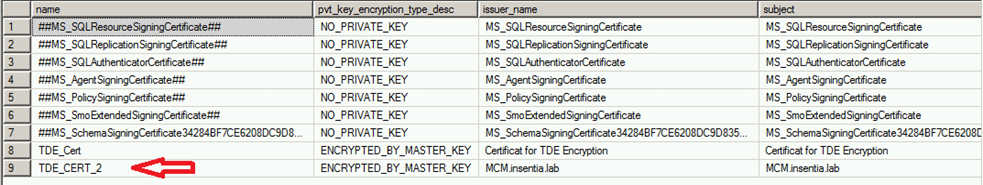

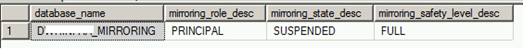

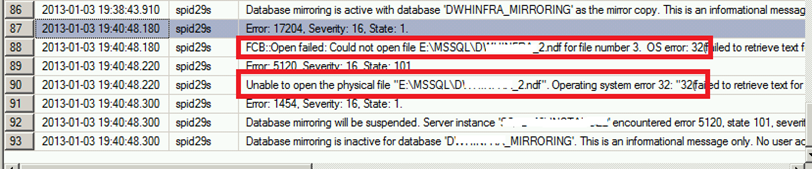

On voit d’abord que le niveau d’isolation de transaction en mode read uncommitted ne veut pas dire qu’il n’existe plus de verrou. Le 1er verrou (de type SHARED_TRANSACTION_WORKSPACE) nous intĂ©resse moins ici car c’est un verrou posĂ© lorsqu’il existe une connexion sur une base de donnĂ©es (en l’occurence database_id = 6 ici). Cela permet de protĂ©ger la base de donnĂ©es contre les suppressions accidentelles par exemple lorsqu’il existe une connexion sur cette dernière.

Les verrous suivants sont plus intĂ©ressants dans notre cas. On voit que la diffĂ©rence notoire est qu’il existe des verrous de type IS et type S dans un cas (read committed) et plus de verrou de ce type dans l’autre cas (read uncommitted). Le niveau d’isolation de transaction par dĂ©faut utilisĂ© par SQL Server garantit une lecture propre des donnĂ©es c’est la raison pour laquelle il existe des verrous de type S et IS Ă diffĂ©rents niveaux (OBJECT et PAGE) . Avec le niveau d’isolation permettant de la lecture sale ces verrous n’existent Ă©videmment plus mais d’autres verrous existent cependant comme celui que l’on voit dans la dernière image : verrou de type Sch-S. Ce verrou protège la table contre les modifications pendant qu’une lecture est effectuĂ©e mĂŞme si celle-ci n’est pas propre.

Faisons le mĂŞme test avec une table HEAP (sans index cluster) avec la requĂŞte suivante :

FROM dbo.DatabaseLog AS f

CROSS JOIN dbo.DatabaseLog AS f2

… et voyons les verrous posĂ©es :

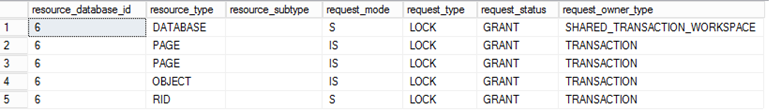

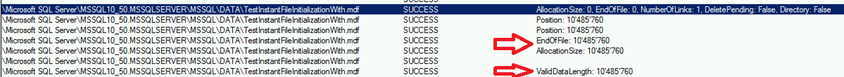

![]() Avec un niveau d’isolation de transaction en read committed (niveau d’isolation par dĂ©faut) :

Avec un niveau d’isolation de transaction en read committed (niveau d’isolation par dĂ©faut) :

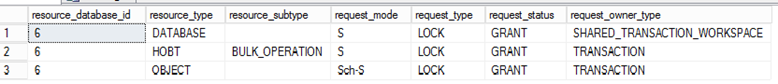

![]() Avec un niveau d’isolation de transaction en read uncommitted :

Avec un niveau d’isolation de transaction en read uncommitted :

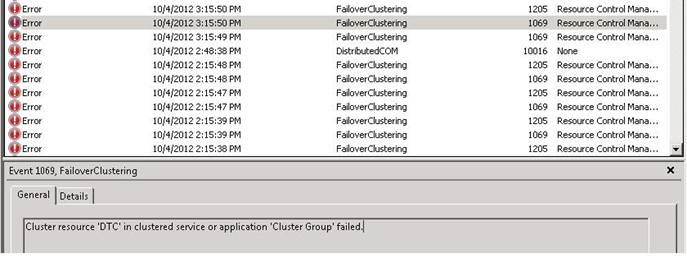

La aussi on peut voir qu’avec les verrous de type S ne sont plus prĂ©sents sur les objets de type PAGE ou OBJET avec un niveau d’isolation de transaction en read uncommitted. On a nĂ©anmoins un type de verrou supplĂ©mentaire que l’on n’avait pas avec une table possĂ©dant un index cluster Ă la ligne 2 (resource_type = HOBT et resource_subtype = BULK_OPERATION). Ce type de verrou n’est prĂ©sent que sur les tables HEAP pour protĂ©ger les lectures contre les pages potentiellement mal formatĂ©s via des opĂ©rations BULK (merci Ă Paul Randal pour la prĂ©cision).

On vient donc de voir que la lecture sale sur SQL Server engendrait certains types de verrous. Cependant on peut pousser le raisonnement plus loin. Qui dit verrou veut dire aussi latch pour accĂ©der aux structures physiques en mĂ©moire … on peut essayer de voir si une requĂŞte avec un niveau d’isolation en read uncommitted produit des latchs. Pour cela on peut utiliser la DMV sys.dm_os_waiting_tasks comme ceci :

SELECT TOP 1 *

INTO #waiting_tasks

FROM sys.dm_os_waiting_tasks;

GO

TRUNCATE TABLE #waiting_tasks;

GO

WHILE 1 = 1

BEGIN

INSERT #waiting_tasks

SELECT *

FROM sys.dm_os_waiting_tasks

WHERE SESSION = "session"

END

En parallèle la requête suivante est lancée :

FROM dbo.DatabaseLog AS f

CROSS JOIN dbo.DatabaseLog AS f2

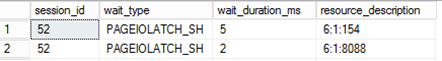

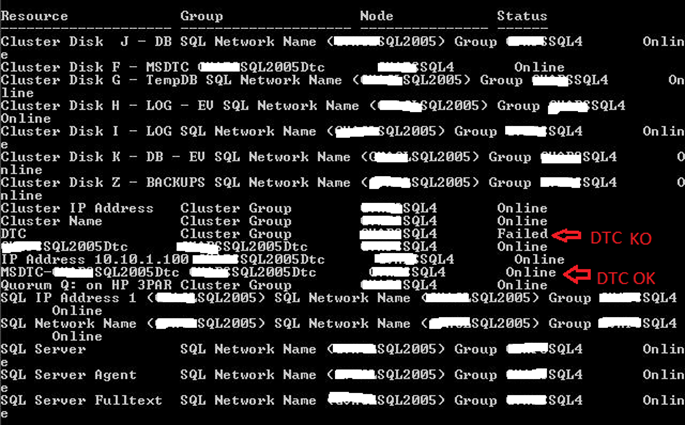

Après avoir lancĂ© une des requĂŞtes avec un niveau d’isolation de transaction en read uncommitted on peut constater que cette dernière a effectivement gĂ©nĂ©rĂ©e des latchs de type SH dans notre cas :

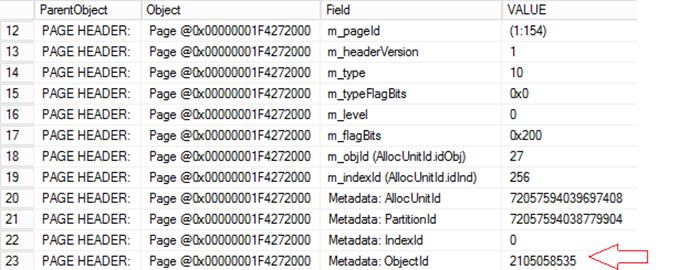

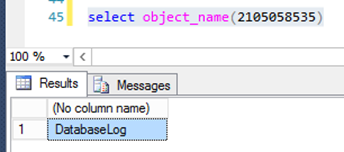

On peut regarder Ă quel objet appartient la page 154 par exemple :

GO

DBCC PAGE(6, 1, 154) WITH TABLERESULTS;

GO

…

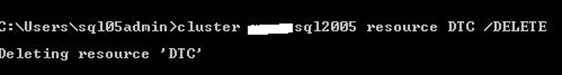

Pour conclure l’idĂ©e que l’utilisation de la lecture sale avec SQL Server ne gĂ©nère pas de verrous est faussĂ©e. Certains les verrous de type S pouvant gĂŞner les Ă©critures sont absents mais on a pu constater au cours de ce billet que d’autres types de verrous Ă©taient et bien prĂ©sents ainsi que des latchs pouvant mĂŞme aboutir Ă une potentielle contention !!

Bonne utilisation de lecture sale ![]()

David BARBARIN (Mikedavem)

MVP SQL Server